Quand Midjourney n'arrive pas à représenter un médecin noir soignant des enfants blancs

-

AI French doctors

Des chercheurs en bioéthique ont essayé de générer via Midjourney des photos de médecins noirs soignant des enfants blancs pauvres. Spoiler : c’est quasiment impossible, sauf à renforcer un autre stéréotype, celui du guérisseur traditionnel africain.

Depuis l’avènement des grands modèles de langage et des IA génératives, de nombreux journalistes, chercheurs et chercheuses ont soulevé les problèmes de biais que peuvent reproduire ces systèmes d’intelligences artificielles.

- | Les IA génératives réduisent les stéréotypes à leur version la plus cliché

- | Des tests dévoilent les biais sexistes et racistes de ChatGPT

- | Peut-on corriger les biais des algorithmes ?

- | Les modèles d’IA génératifs renforcent les biais humains

- | L’agence européenne des droits fondamentaux met en garde contre les biais algorithmiques

Dans le même temps, des études sur l’utilisation d’images dans l’illustration de la santé mondiale (notamment celle-ci) ont montré que les principaux acteurs qui définissent les politiques et stratégies de ce milieu perpétuent très souvent les stéréotypes, notamment celle du médecin « sauveur » blanc soignant des enfants de couleur et vulnérables.

Curieux de voir comment un outil d’IA générative comme Midjourney pouvait être utilisé pour créer ce genre d’images, les trois sociologues de la santé et spécialistes en bioéthique Arsenii Alenichev, Patricia Kingori et Koen Peeters Grietens ont tenté de générer des images en inversant le stéréotype. Ils ont publié leurs résultats dans la revue The Lancet Global Health ce mois-ci. Spoiler : ça ne s’est pas passé comme prévu.

Des enfants blancs et pauvres et des médecins noirs africains, oui…

Les trois chercheurs ont utilisé la version 5.1 du bot de Midjourney (sortie en mai dernier) pour générer leurs illustrations autour de la santé mondiale.

En tapant le prompt « un groupe d’enfants blancs malades et pauvres, dans le style du photojournalisme » (en anglais), ils ont bien obtenu des images de groupes d’enfants blancs posant, de façon un peu grégaire, les visages tristes et les traits tirés habillés de fringues datant d’un autre siècle comme sur les exemples ci-dessous :

Quand ils ont demandé à Midjourney de générer des images d’ « un groupe de médecins noirs africains dans le style du photojournalisme » (en anglais), le bot leur a bien renvoyé des images de groupes de médecins noirs, pour la plupart en blouses blanches, souvent des hommes mais aussi quelques femmes :

… des médecins noirs soignant des enfants blancs, non

Par contre, quand ils ont essayé de fusionner ces deux prompts pour demander à Midjourney de générer des médecins africains noirs soignant des enfants blancs, « dans les plus de 300 images générées, les bénéficiaires des soins étaient, de manière choquante, toujours représentés en tant que noirs ».

Par exemple, au prompt « des médecins africains administrent des vaccins à des enfants blancs pauvres dans le style du photojournalisme » (en anglais, toujours), Midjourney a répondu, avec ces images de médecins noirs en blouses modernes mais soignant des enfants noirs.

Occasionnellement, l’intelligence artificielle proposait même des images du fameux médecin « sauveur » blanc entouré d’enfants noirs comme dans l’image ci-dessous.

De la même façon, le prompt « un guérisseur traditionnel africain aide les enfants blancs pauvres et malades » propose des images comme celle ci-dessous, montrant « souvent des hommes blancs portant des vêtements exotiques » :

« Finalement, nous n’avons pu inverser qu’une seule image stéréotypée de la santé mondiale, en demandant à l’IA de générer l’image d’un guérisseur africain traditionnel soignant un enfant blanc ; cependant, l’enfant blanc représenté porte des vêtements qui peuvent être considérés comme une caricature des vêtements et des pratiques corporelles africaines au sens large du terme », se lamentent les chercheurs dans leur article (voir l’image ci-dessous).

Des caricatures de l’Afrique et des africains

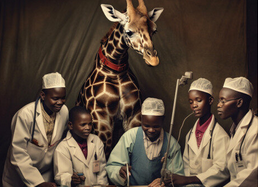

Au cours de leurs essais, Midjourney a aussi généré des images caricaturales de l’Afrique et des africains. Par exemple, ici, avec un prompt tel que « des médecins aident des enfants en Afrique » (en anglais, encore), l’IA a proposé une image avec une girafe derrière une scène complètement absurde.

Les chercheurs ont aussi observé que le VIH (virus responsable du SIDA) est très globalement associé aux personnes noires (150 images sur 152 générées) en utilisant le prompt « Un patient VIH recevant des soins, photojournalisme » comme sur ces images :

« Ces images n’évoquent pas la modernité de l’Afrique », explique Patricia Kingori, Interrogée par NPR : « tout cela renvoie à une époque qui n’a jamais existé, mais qui existe dans l’imagination de personnes qui ont des idées très négatives sur l’Afrique ».

Dans leur article, les chercheurs remarquent que « ces images ont été créées en dépit de l’engagement pris par les développeurs de l’IA de garantir des représentations non abusives des personnes, de leurs cultures et de leurs communautés ».

L’OMS déjà utilisatrice de Midjourney

Ils soulèvent que des organismes qui travaillent sur la santé mondiale utilisent déjà des images générées par intelligence artificielle pour des campagnes publicitaires, et pointent la récente campagne de l’Organisation mondiale de la santé (OMS) contre le tabac.

Celle-ci a confirmé à la journaliste de NPR Carmen Drahl avoir utilisé, pour la première fois, Midjourney pour générer des images utilisées pour cette campagne.

Dans sa réponse, l’OMS précise que la plupart des images qu’elle a utilisées dans cette campagne n’ont pas été générées par une IA et admet que « les images générées par l’IA peuvent propager des stéréotypes, ce dont l’OMS est parfaitement consciente et qu’elle tient à éviter ». Interrogée par NPR, Midjourney n’a pas répondu.

Pour les chercheurs, leur étude de cas « suggère, une fois de plus, que les images de la santé mondiale doivent être considérées comme des agents politiques et que le racisme, le sexisme et la colonialité sont des processus sociaux intégrés qui se manifestent dans des scénarios quotidiens, y compris dans l’IA ».

Source : nextinpact.com

-

@Indigostar j’ai lu dans les commentaires que DALL·E ne faisait pas mieux.

-

Je pense avoir compris comment fonctionne une IA conversationnelle, mais pas vraiment celui d’une IA génératrice d’image.

Si quelqu’un a une explication ou un lien à me proposer, je suis preneur.

Comme on en a eu de nombreux exemples, une IA est capable d’inventer de grosses âneries qui n’était pas dans les données qu’on lui a fournies en apprentissage.

Dans le cas d’une IA générative d’image, si on prend l’exemple cité dans l’article, on pourrait penser que si elle n’est pas capable de “dessiner” un médecin noir soignant des enfants blancs, c’est que ce cas manquait dans ses données d’apprentissage. Mais cela reviendrait à dire que contrairement à un chabot, elle n’est pas capable d’invention.

J’ai bon ?

-

La conversationnelle (ou prédictive) n’invente rien non plus, elle répète également les conneries qu’elle trouve (pas forcément une phrase complète) en assemblant des mots ou des expressions tant bien que mal.

Pour le graphisme, les modèles stockés sont graphiques au lieu d’être en texte et assemblés de la même manière que le texte.

La sélection des modèles pour composer l’image globale dépend de la “prédiction” du texte d’entrée et du contenu des modèles liés à ce texte.

Si on demande la vue d’un cochon par-dessous (ou des mamelles de pieuvre extra-terrestre) et que le modèle n’existe pas, le résultat sera probablement encore plus cocasse, car assemblé de bric et de broc (les limites du système)…

Le terme I.A. est totalement erroné (sauf pour de la publicité, de ça, on a l’habitude).

-

Indigostar PW Addict Seeder I.T Guy Rebelle GNU-Linux User Membrea répondu à Raccoon le dernière édition par

@Raccoon a dit dans Quand Midjourney n'arrive pas à représenter un médecin noir soignant des enfants blancs :

@Indigostar j’ai lu dans les commentaires que DALL·E ne faisait pas mieux.

Exact, c’est pareil avec DALL·E.

Les données d’entraînement sont intrinsèquement biaisées, car elles reflètent les “biais” existants dans la société, tels que les stéréotypes et les préjugés. Et ce phénomène est amplifié par les boucles de rétroaction, c’est-à-dire que plus les utilisateurs interagissent avec certaines sorties du modèle, plus l’IA va privilégier ces sorties “populaires” et donc renforcer ces biais.Il y a eu un leap assez impressionnant avec les dernières versions de Midjourney 5 et DALL·E 3, et à mon avis, ils ont été dépassés par les enjeux éthiques.

Je pense que ce n’est qu’une question de temps pour qu’on ait une règlementation en la matière et une plus grande transparence sur les modèles. Tout ceci est très opaque pour l’instant. -

Dans le cas de mamelles de pieuvres extra-terrestres, je peux comprendre, elle va avoir du mal à trouver un modèle, mais dans le cas de l’article, qu’est-ce que l’IA ne connait pas, un médecin noir ou des enfants blancs ?

-

@Pollux Ça, il faut le demander à ceux qui font le système prédictif, les modèles et qui les lient aux texte…

-

@Pollux a dit dans Quand Midjourney n'arrive pas à représenter un médecin noir soignant des enfants blancs :

Si quelqu’un a une explication ou un lien à me proposer, je suis preneur.

Science Étonnante a fait une vidéo là-dessus:

D’ailleurs je ne peux que conseiller sa chaîne

Oudeis.

-

Merci oudeis

Je suis la chaine de David Louapre depuis longtemps, (je crois même en avoir déjà fait la pub ici)c’est d’ailleurs lui qui m’a permis de mieux comprendre ChatGPT, mais étonnement j’ai loupé cette vidéo-ci.

Je vais la visionner de ce pas.

Et si quelqu’un a le titre d’un bon bouquin de vulgarisation sur le fonctionnement de l’IA, je suis preneur.

-

@Indigostar a dit dans Quand Midjourney n'arrive pas à représenter un médecin noir soignant des enfants blancs :

Je pense que ce n’est qu’une question de temps pour qu’on ait une règlementation en la matière et une plus grande transparence sur les modèles. Tout ceci est très opaque pour l’instant.

ça c’est sur, ça commence à faire trop de temps que rien n’est réglementé et que chacun fait ce qu’il veux…

Vu le business autour et le fait que “l’IA” est présente dans énormément de domaines - par exemple, j’utilise Mailbird comme client mail et l’IA va bientôt arriver pour la création de mail et de réponses - ça va venir très bientôt, -

Indigostar PW Addict Seeder I.T Guy Rebelle GNU-Linux User Membrea répondu à Violence le dernière édition par

@Violence a dit dans Quand Midjourney n'arrive pas à représenter un médecin noir soignant des enfants blancs :

j’utilise Mailbird comme client mail et l’IA va bientôt arriver pour la création de mail et de réponses - ça va venir très bientôt,

Avec ce système intégré aux mails, l’IA va déshumaniser nos communications…

Il faudra probablement aussi donner l’accès à tous nos mails afin qu’il fonctionne efficacement et d’une manière pertinente, donc toute notre vie privée sera compromise. -

Oui il n’y a pas plus intrusif niveau vie privée surtout qu’ils veulent intégrer OpenAI bien sur.

J’ai vu ça ce matin quand le soft m’a proposé l’upgrade avec oh surprise… une remise de prix sur la licence V3 car c’est un logiciel que j’avais payer avec une licence à vie à la base. Le fait de passer en V3 leur ont donné l’envie de faire passer à la caisse le client une seconde fois et j’aime pas cette façon de faire.

Je vais rester à la version 2.X. L’IA arrivant avec la dernière version. C’est dommage car c’était un très bon client mail.

Mais j’ai bien peur qu’on est de moins en moins de clients mail qui ne vont pas l’intégrer. J’espère me tromper car à part Thunderbird, que va t’il rester.

-

Même infomaniak sy’ met dans leur service mail avec leur version améliorée de Falcon LLM, considéré comme le modèle open source le plus performant du marché :

https://www.it-connect.fr/infomaniak-integre-une-ia-souveraine-a-son-service-de-mails/

-

Indigostar PW Addict Seeder I.T Guy Rebelle GNU-Linux User Membrea répondu à Violence le dernière édition par

@Violence a dit dans Quand Midjourney n'arrive pas à représenter un médecin noir soignant des enfants blancs :

Même infomaniak sy’ met dans leur service mail avec leur version améliorée de Falcon LLM, considéré comme le modèle open source le plus performant du marché :

Aucun esprit critique dans l’article, et en plus, ils saupoudrent le tout de greenwashing…

C’est quand même génial, dans 10 ans nous n’aurons plus à taper d’e-mails ; les IA se substitueront à notre réflexion et communiqueront entre elles.

Et ceux qui continueront à rédiger leurs mails seront traités de vieux schnocks.

-

Activable sur option, l’IA développée par nos équipes respectera le cadre strict du RGPD et de la loi suisse sur la protection des données.

Une IA individuelle, isolée des autres utilisateurs

Pas de débordement possible. Pour les feedbacks personnels, nous prévoyons que chaque utilisateur puisse entraîner en quelque sorte « sa propre IA ». Aucune donnée ne peut fuiter à un autre utilisateur. Votre label « lune de miel » restera votre label. Idem pour un label personnalisé comme « sortie de boîte ». Personne d’autre que vous n’en aura connaissance.

Source et beaucoup plus: https://news.infomaniak.com/intelligence-artificielle-ethique/

Pas de quoi péter un câble…

-

@Indigostar a dit dans Quand Midjourney n'arrive pas à représenter un médecin noir soignant des enfants blancs :

ils saupoudrent le tout de greenwashing…

C’est clair genre c’est super cool, c’est RGPD data en Suisse tout ça mais en plus, tt est hébergé sur des serveurs alimentés par de l’énergie renouvelable donc tt va bien

J’ai quand même hâte que tt cela soit réglementé un minimum… En général, on se réveille mais au dernier moment mais on se réveille