Infrastructures de recherche : l’épopée des géants

[image: 1_kittpeaknoirlab2512m_vp.jpg?itok=MH13ecsa]

Des coupes budgétaires menacent l’observatoire de Kitt Peak, en Arizona (États-Unis).

Des installations astronomiques aux accélérateurs de particules, les grandes infrastructures de recherche ont façonné l’histoire des sciences. Mais elles se retrouvent aujourd’hui au cœur de débats budgétaires et géopolitiques qui conditionnent leur avenir.

Étoiles, comètes, gravité, reproduction… Depuis des millénaires, les humains tentent de comprendre les phénomènes dont ils sont témoins. L’astronomie, en particulier, les a poussés à développer des instruments pour décrypter le ciel.

Longtemps, ces observations se sont faites à l’œil nu, en s’aidant d’une règle montée sur un trépied pour mesurer la hauteur d’une étoile. Il faudra attendre la fin du XVIe siècle pour voir apparaître la lunette. Galilée commence à l’utiliser à l’été 1609.

Quelques mois plus tard, il réalise ses premières découvertes. Il convainc progressivement la plupart des astronomes de l’époque, notamment Johannes Kepler, du caractère indispensable de cet outil. Quant au télescope, il sera inventé entre la fin du XVIIe et le début XVIIIe siècle par des savants comme Isaac Newton et James Gregory.

[image: 3_wellcome_voo24831_horiz_cut_72dpi.jpg?itok=uEF5WxfW]

Galilée observe le ciel avec sa lunette astronomique, sur la place Saint-Marc, à Venise (gravure sur bois).

Les premiers grands équipements

C’est aussi à l’époque moderne qu’est fondé ce qui peut être considéré comme le premier grand équipement de l’histoire. « Situé sur l’île de Ven, entre la Suède et le Danemark, l’observatoire de Tycho Brahe, à la fin du XVIe siècle, est grand pour son époque, décrit Jérôme Lamy, historien et sociologue des sciences au CNRS [1]. Les observations s’y font à l’œil nu, mais il s’agit d’une véritable usine scientifique qui a vu passer plus de 150 élèves ou assistants, dédiés à l’entretien du matériel ou aux calculs. On y trouve un local pour les instruments, une presse pour publier les résultats, et même un petit laboratoire d’alchimie. »

Tout comme son confrère Vincent Simoulin [2].

Un bond en avant

Entre le XVIIIe et le XIXe siècle, les grands équipements se spécialisent, avec une professionnalisation des pratiques scientifiques. Il faut être reconnu dans sa discipline pour y entrer. La standardisation des protocoles d’enquête ouvre en outre la possibilité de délégations techniques.

L’exemple de l’observatoire de Toulouse, auquel Jérôme Lamy a consacré sa thèse, illustre les avancées de cette période : « Il est fondé dans les années 1840, lorsque les autorités remarquent la nécessité d’avoir, en province, un observatoire compétent. La construction d’un grand télescope de 80 cm est financée dans les années 1850-1860. Après la défaite contre la Prusse, en 1871, la IIIe République décide de fonder une puissance scientifique française. L’astronomie connaît alors un bond en avant. L’observatoire intègre le projet scientifique international “Carte du ciel” grâce à son astrophotographe, et va jusqu’à mener des expériences de magnétisme terrestre. »

[image: 2_istock-1522894609_72dpi.jpg?itok=29egOR08]

Le Jantar Mantar, observatoire astronomique édifié à Jaipur, au Rajasthan (Inde), à partir de 1727.

La mondialisation astronomique

Dans l’entre-deux-guerres, ce qui est alors le plus grand télescope du monde, doté d’un miroir de 5 m de diamètre, est construit sur le mont Palomar, en Californie. C’est le début d’une course au gigantisme. Le télescope Hale voit sa première lumière en 1949.

« Les astronomes du monde entier essaieront d’en bâtir des répliques, mais la construction de tels télescopes réclame des investissements colossaux, explique Pascal Marichalar [3], sociologue et historien des sciences. C’est pourquoi les scientifiques se lancent dans des collaborations entre différentes universités et pays, tout en cherchant les meilleurs sites au monde. Jusqu’alors, on installait généralement les télescopes à proximité des universités, dans des endroits accessibles. À partir des années 1950, on déconnecte géographiquement l’emplacement de la grande infrastructure de recherche en astronomie. »

En 1954, six pays européens signent une charte en vue de créer l’European Southern Observatory (Eso, ou Observatoire européen austral), afin de construire un grand télescope dans l’hémisphère Sud. Le Chili est choisi en raison de son ciel exceptionnellement peu nuageux. Vingt-cinq ans plus tard, le grand télescope international Canada-France-Hawaii, cogéré par le CNRS, est édifié sur le Mauna Kea, à Hawaii.

Depuis, des innovations techniques ont permis de concevoir des télescopes encore plus grands que le Hale californien : miroir segmenté (formé de dizaines, voire de centaines de petits miroirs hexagonaux assemblés) comme pour le futur Extremely Large Telescope européen, au Chili ; miroir en ménisque fin, permettant de corriger les aberrations optiques dues à la forme du miroir primaire, comme celui du télescope national japonais Subaru, sur le Mauna Kea ; ou encore, miroirs en nid d’abeille, plus légers car soutenus par un support alvéolaire, qui équiperont le Giant Magellan Telescope, en chantier au Chili.

[image: eelt_dji_0407_72dpi.jpg?itok=cKnssR0a]

La coupole du futur Extremely Large Telescope (ELT) de l’European Southern Observatory (Eso), au Chili, en janvier 2025. Ce télescope géant, muni d’un miroir primaire d’un diamètre de 39 mètres, devrait offrir ses premières lumières en 2029.

Le Cern, référence en physique des particules

L’après-guerre voit la course au gigantisme instrumental gagner toutes les disciplines, en particulier dans la physique des particules. Créé en 1954, et à cheval entre la France et la Suisse, le Cern (Conseil européen pour la recherche nucléaire) devient une référence dans le domaine des grandes infrastructures scientifiques de coopération internationale.

« L’équipement, qui mobilise des équipes de milliers de personnes et des communautés scientifiques entières, accueillera en 2008 le plus grand et le plus puissant accélérateur de particules au monde, le Large Hadron Collider (LHC), rappelle Jérôme Lamy. Son activité suppose une organisation et une logistique d’une complexité rare et totalement innovantes. »

« De nombreuses découvertes majeures seront réalisées au Cern (des courants neutres aux bosons W et Z, et plus récemment, en 2012, le boson de Higgs) grâce au LHC », souligne Michel Guidal, résident du Comité TGIR (Très grandes infrastructures de recherche) du CNRS.

La physique des particules s’adosse fortement à cet équipement unique au monde. Mais les grandes infrastructures se sont également multipliées dans d’autres domaines de recherche, souvent dans le cadre de coopérations internationales.

Des technologies à la pointe de la science

« Le Super-Kamiokande, construit au Japon en 1994, et le Sudbury Neutrino Observatory, au Canada (mis en opération en 1999), ont mené des expériences souterraines autour de la physique des neutrinos, poursuit Michel Guidal. Comme pour le Cern, des prix Nobel y ont été associés, avec des moyens colossaux et des technologies à la pointe de la science. »

En France et en Europe, les grandes infrastructures de recherche (IR) sont labellisées. « En ce qui concerne la France, elles sont une centaine et peuvent parfois être localisées hors de l’Hexagone. » Vingt-cinq d’entre elles, appelées « IR étoile » (IR*), sont considérées comme stratégiques. Parmi celles-ci : l’Institut Laue-Langevin, l’European Synchrotron Radiation Facility (ESRF), le Grand accélérateur national d’ions lourds (Ganil), la base franco-italienne Concordia, en Antarctique, ou encore l’Eso, au Chili.

[image: 4-cnrs_20080001_0280_72dpi.jpg?itok=YdL089Uo]

Télescope Cochise de 2,6 mètres, sur la station franco-italienne Concordia (Antarctique), une infrastructure de recherche considérée comme stratégique.

« Ces infrastructures, souvent internationales de par leur envergure, peuvent concerner tous les domaines : physique, chimie, astrophysique, biologie, informatique, sciences humaines et sociales, etc. », précise Michel Guidal. Mais, si cette internationalisation ouvre des perspectives inédites pour la recherche, elle s’accompagne aussi de nouveaux défis, qu’ils soient de nature environnementale, politique et budgétaire, voire territoriale.

Télescopes, des terrains de désaccord

Un exemple emblématique, relaté par Pascal Marichalar : « L’invention et la généralisation de l’interférométrie , depuis les années 1980, ont poussé les astronomes à imaginer des réseaux de télescopes connectés, au lieu d’un seul dôme, ce qui démultiplie la surface occupée par des instruments. C’est ainsi que le Mauna Kea, à Hawaii, est devenu un symbole de la tendance invasive des infrastructures de recherche [4] *. Dans les années 1990, cette montagne, sacrée pour les autochtones, est devenue le point focal d’une contestation hawaïenne souhaitant réaffirmer ses droits sur son territoire. »

D’abord annulé par la Cour suprême d’Hawaii pour des vices de procédure dans le permis de construire, le Thirty Meter Telescope (TMT) a été de nouveau autorisé en 2019, soulevant un mouvement de blocage du site par des milliers de personnes pendant des mois.

[image: 5_rea7922987_72dpi.jpg?itok=cuVzyne0]

Blocage sur une route pour protester contre la construction du Thirty Meter Telescope sur le Mauna Kea, à Hawaii, en 2019.

L’acceptabilité des investissements

De même, le projet du Futur Collisionneur Circulaire (FCC) du Cern (estimé à plus de 16 milliards d’euros financés par une trentaine de pays, et projeté à l’horizon 2040) suscite des controverses au sein même de la communauté scientifique.

« Le FCC pourrait permettre d’étudier extrêmement finement les propriétés du boson de Higgs et de mener des recherches fondamentales autour de la matière noire, par exemple, pointe Michel Guidal. Les découvertes n’étant jamais garanties, il faut désormais intégrer la question de l’acceptabilité de ces investissements par la société, dans un contexte de crise économique et environnementale. »

Et ce, malgré le fait que ces découvertes génèrent aussi souvent des retombées très concrètes et immédiates : « On peut notamment rappeler que les recherches du Cern ont mené à la création du Web, ou encore que l’IR Neurospin, sur le plateau de Saclay, produit une imagerie à résonance magnétique nucléaire grâce à la technologie d’aimants supraconducteurs développée au Cern. Cet appareil permet de réaliser une visualisation médicale extrêmement fine, avec une application concrète dans la santé. »

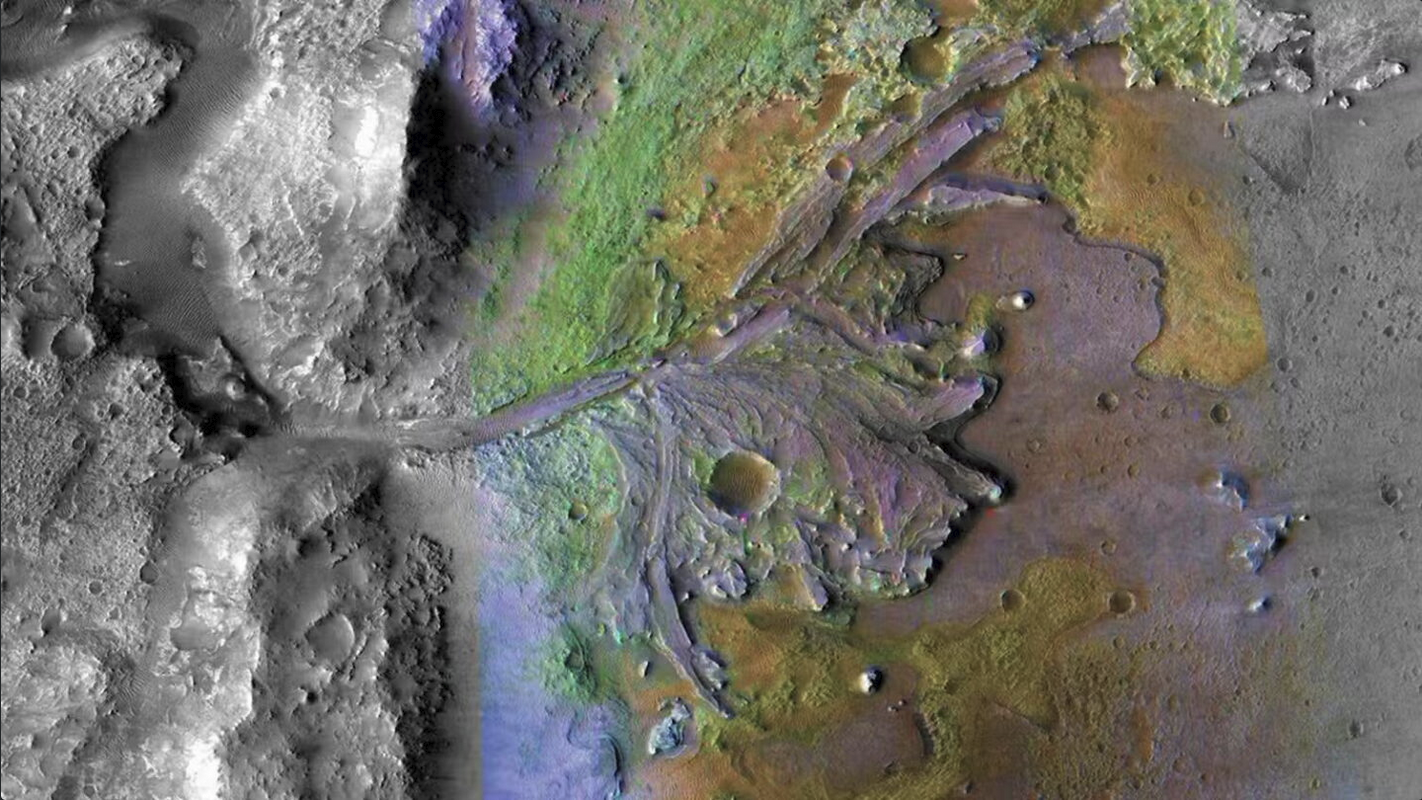

Coupes budgétaires aux États-Unis

Les revirements politiques nationaux peuvent aussi mettre à mal des collaborations internationales. « Les coupes budgétaires énormes dans la National Science Foundation, voulues par l’administration Trump dans le budget 2026, pourraient menacer le bon fonctionnement de certains instruments : celui de Kitt Peak (Arizona), la moitié de l’observatoire Gemini, basé entre Hawaii et le Chili, ou encore l’un des détecteurs d’ondes gravitationnelles du projet Ligo-Virgo, détaille Pascal Marichalar. Sans oublier les coupes dans le budget de la Nasa qui menacent notamment la mission de la sonde Juno (qui étudie Jupiter, Ndlr) ou le retrait probable des Américains du financement du radiotélescope Alma (interféromètre de 66 antennes, Ndlr), au Chili, qui associe l’Europe, le Japon et les États-Unis. Des dizaines de missions devraient être fermées du jour au lendemain. Une décision incompréhensible pour les astronomes. »

Bien que le financement de certaines grandes infrastructures semble actuellement en péril, notons qu’il n’y a jamais eu autant de collaborations scientifiques internationales qu’aujourd’hui. Nous vivons bien un âge d’or de l’instrumentation de grande envergure.

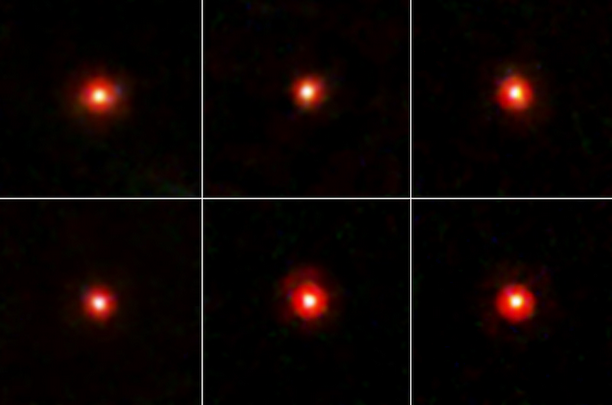

À preuve, le lancement de télescopes spatiaux tels que James Webb (en 2021) et Euclid (en 2023), le démarrage en juin 2025 de l’observatoire Vera C. Rubin, qui exploite la plus grande caméra du monde (construite en partie dans les laboratoires du CNRS), ou encore le détecteur de neutrinos KM3Net, déployé au fond de la Méditerranée. Tous ces instruments sont tournés vers la même ambition : percer les mystères de l’Univers.

----------------------------------

En sciences humaines et sociales, des infrastructures immatérielles et distribuées

En sciences humaines et sociales (SHS), de grandes infrastructures se sont constituées dans les années 2000, dans un contexte marqué par deux dynamiques convergentes. D’abord, la prise de conscience par les décideurs scientifiques d’un retard français en matière de structuration, de diffusion et de valorisation de la donnée. Ensuite, l’affirmation progressive des principes de la science ouverte au niveau européen.

« Contrairement aux infrastructures des sciences dites expérimentales, celles en SHS ne reposent pas sur des équipements massifs ou des sites uniques. Elles sont plutôt immatérielles et distribuées, c’est-à-dire basées sur des logiques de coordination entre entités et acteurs, souvent distants géographiquement, souligne Frédéric Gonthier, professeur à Sciences Po Grenoble, membre du Laboratoire de sciences sociales [5] et de l’infrastructure de recherche Progedo. D’autre part, leur fondement est davantage méthodologique que technique : il s’agit d’organiser la production, l’archivage, la documentation et l’accès aux données selon des standards communs, et de garantir leur réutilisation scientifique. »

Les infrastructures Progedo et Huma-Num, aujourd’hui labellisées IR étoile [6], sont emblématiques de ce modèle. Le service le plus connu chez Huma-Num est l’assistant de recherche Isidore, qui offre aux chercheurs un portail via lequel ils ont accès, en français, anglais et espagnol, à l’ensemble de la publication scientifique française ainsi qu’à une partie de la publication européenne.

« Dans l’IR Huma-Num, il existe une organisation assez originale à travers les consortiums, des groupes de chercheurs financés sur quatre ans avec deux objectifs : faire monter en compétences la communauté dans une discipline, avec pilotage par des chercheurs », explique Jean-Luc Minel, président du conseil scientifique d’Huma-Num.

« Ces approches se sont avérées particulièrement fécondes, notamment grâce aux grandes enquêtes comparatives, qui sont devenues de véritables instruments de connaissance, comparables aux télescopes dans l’astronomie ou aux séquenceurs dans la génomique, assure Frédéric Gonthier. Elles produisent des données publiques de haute qualité, systématiquement documentées et réutilisables. »

Source : https://lejournal.cnrs.fr/articles/infrastructures-de-recherche-lepopee-des-geants

1

1

1

1

10

10

3

3

2

2