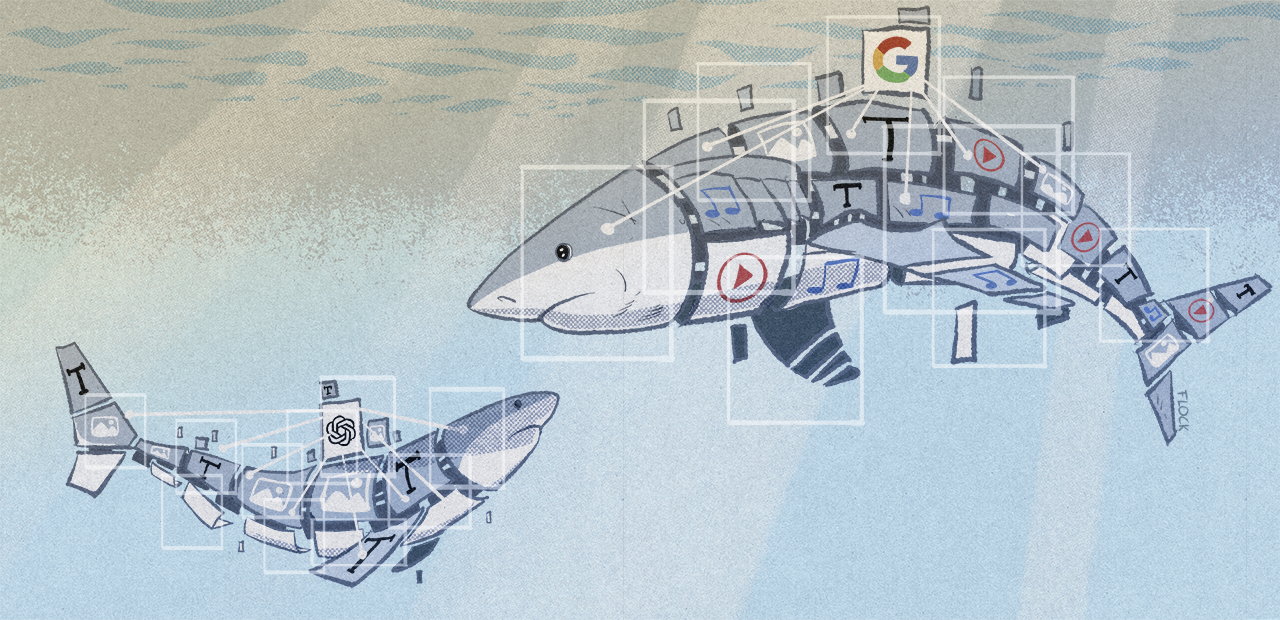

D’anciens salariés d’OpenAI et Google demandent un droit d’alerter sur les risques des IA

-

Une lettre ouverte signée par des anciens salariés d’OpenAI et de Google DeepMind réclame la possibilité d’exprimer leurs préoccupations sur les dangers des IA les plus avancées. Certains signataires sont restés anonymes par peur de possibles représailles. Le texte est aussi soutenu par Yoshua Bengio, Geoffrey Hinton et Stuart Russell.

Mardi, un petit groupe d’anciens salariés d’OpenAI a publié un texte sur le site Right to warn. Leurs signatures sont accompagnées de celles de Ramana Kumar, un ancien de Google DeepMind et de Neel Nanda, ancien d’Anthropic actuellement en poste chez Google DeepMind.

Cette lettre arrive alors qu’il y a quinze jours, l’équipe chargée de contrôler les IA chez OpenAI a quitté l’entreprise. Elle a déclaré ne pas avoir reçu les moyens qui lui avaient été promis pour travailler sur le sujet. L’entreprise a, depuis, créé un nouveau comité de sécurité, mais celui-ci parait verrouillé par la présence de Sam Altman et Bret Taylor en son sein.

Dans ce contexte, OpenAI a été accusé d’éviter toute critique de ses anciens employés en leur imposant la signature d’un accord de confidentialité (NDA) qui leur interdit de la critiquer.

Seuls à pouvoir sonner l’alarme

Dans leur texte, ces ingénieurs expliquent être en position de comprendre les risques posés par ces technologies : « ces risques vont du renforcement des inégalités existantes à la manipulation et à la désinformation, en passant par la perte de contrôle des systèmes d’IA autonomes pouvant entraîner l’extinction de l’humanité ».

Ils disent « espérer que ces risques pourront être atténués de manière adéquate si la communauté scientifique, les décideurs politiques et le public fournissent des orientations suffisantes ». Mais ils ajoutent que « les entreprises d’IA ont de fortes incitations financières à éviter une surveillance efficace, et nous ne pensons pas que les structures de gouvernance d’entreprise habituelles soient suffisantes pour changer cette situation ».

Pour eux, « tant qu’il n’y aura pas de contrôle gouvernemental efficace de ces entreprises, les employés actuels et anciens sont parmi les rares personnes qui peuvent les mettre devant leurs responsabilités publiquement ».

Mais ils dénoncent les accords de confidentialité qui les « empêchent d’exprimer [leur] préoccupations ». Ils pointent une faille dans la protection des lanceurs d’alerte qui se concentre « sur les activités illégales, alors que bon nombre des risques qui nous préoccupent ne sont pas encore réglementés ».

Dénonciation des accords de confidentialité

Ils demandent donc aux entreprises d’IA de s’engager à : ne plus signer d’accords de confidentialité qui empêchent toute critique des risques liés à l’intelligence artificielle, créer un processus anonymisé de remontée des préoccupations, soutenir une culture de la critique ouverte, et s’engager à ne pas aller à l’encontre d’employés partageant publiquement des informations confidentielles liées à des risques si d’autres processus ont échoué avant.

Ce texte est soutenu par Yoshua Bengio, Geoffrey Hinton et Stuart Russell, des personnalités qui comptent dans cette communauté.

Publication tardive

Cette lettre arrive pourtant tard alors que Timnit Gebru et Margaret Mitchell ont été licenciées par Google fin 2020 et début 2021. Elles travaillaient alors sur la publication de leur article scientifique prévenant déjà des dangers des grands modèles de langage, outils sur lesquels se base l’IA générative.

Interrogée par Ars Technica, Margaret Mitchell (qui travaille maintenant chez Hugging Face) témoigne de la difficulté de lancer l’alerte dans l’industrie de l’IA : « vous devez quasiment renoncer à votre carrière et à votre santé psychologique pour poursuivre en justice une organisation qui, du fait qu’elle est une entreprise, n’a pas de sentiments et dispose des ressources nécessaires pour vous détruire ».

Même si ses préoccupations concernant les dangers des IA ne sont pas les mêmes que celles des auteurs de la lettre, Margaret Mitchell « estime que les préoccupations soulevées par la lettre soulignent le besoin urgent d’une plus grande transparence, d’un meilleur contrôle et d’une meilleure protection pour les employés qui dénoncent les risques potentiels » note Ars Technica.

Mais la chercheuse ajoute que les lois « qui soutiennent de manière disproportionnée les pratiques injustes des grandes entreprises au détriment des travailleurs » doivent être modifiées significativement.

Source : next.ink

-

Skynet is coming…

-

Le plus dangereux selon moi est l’opacité des mécanismes décisionnels de l’IA. Même les créateurs admettent qu’il existe un phénomène de boîte noire ; on ne sait pas exactement comment les décisions sont prises. Il est difficile de déduire une logique dans l’architecture complexe de toutes ces multiples couches de DNN. Et parallèlement, nous allons dépendre de plus en plus de cette technologie dans tous les domaines.

Je reste donc perplexe, surtout que l’évolution de l’IA tend vers la capacité de se mettre à jour elle-même et d’ajuster ses algorithmes.Il n’est pas impossible qu’un jour nous perdions la main alors que l’IA soit implantée dans tous nos systèmes. Je me dis que si la plupart des grands spécialistes chez OpenAI, Google, Meta, ect. tirent la sonnette d’alarme c’est qu’ils discernent des menaces que nous sous-estimons et qui pourrait s’avérer vraiment désastreuses.

-

Tant qu’on peut débrancher ou supprimer… ça va

-

Indigostar PW Addict Seeder I.T Guy Rebelle GNU-Linux User Membrea répondu à duJambon le dernière édition par Indigostar

@duJambon a dit dans D’anciens salariés d’OpenAI et Google demandent un droit d’alerter sur les risques des IA :

Tant qu’on peut débrancher ou supprimer… ça va

Oui, c’est sûr. Et pour l’instant tout ceci peut faire sourire, car l’intégration de l’IA dans nos systèmes est encore relativement superficielle. Mais à mesure que celle-ci sera plus profondément implémentée dans nos infrastructures, la possibilité de simplement la ‘débrancher’ pourrait devenir beaucoup plus complexe.

-

@Indigostar a dit dans D’anciens salariés d’OpenAI et Google demandent un droit d’alerter sur les risques des IA :

Je reste donc perplexe, surtout que l’évolution de l’IA tend vers la capacité de se mettre à jour elle-même et d’ajuster ses algorithmes.

On devrait lui confier la gestion d’un pays imaginaire histoire de voir.