La filiale de Tata Motors avait été touchée par une cyberattaque fin août, la contraignant à mettre hors ligne ses systèmes informatiques et à arrêter la production dans ses sites britanniques pendant au moins cinq semaines. En dehors des 2,19 milliards d’euros de pertes, 5000 organisations ont été indirectement impactées au Royaume-Uni.

[image: 001532921_896x598_c.jpg]

“L’événement cybernétique le plus dommageable économiquement à avoir frappé le Royaume-Uni” : le Cyber Monitoring Centre (CMC), organisation britannique composée de professionnels de la cybersécurité, ne mâche pas ses mots pour évoquer la cyberattaque subie par Jaguar Land Rover. Elle estime dans un rapport publié ce 22 octobre que l’incident a coûté à l’économie britannique 1,9 milliard de livres sterling (2,19 milliards d’euros) et qu’il a perturbé le fonctionnement de plus de 5000 organisations basées au Royaume-Uni.

2 700 organisations sérieusement impactées

“La fourchette de pertes modélisée est comprise entre 1,6 et 2,1 milliards de livres sterling, mais ce montant pourrait être plus élevé en cas d’impact significatif sur la technologie opérationnelle ou de retards imprévus dans le retour de la production, précise le CMC. Cette estimation reflète les perturbations importantes subies par la production de JLR, sa supply chain à plusieurs niveaux et les organisations en aval, y compris les concessionnaires.” Il ajoute que sur les 5000 organisations impactées, 2 700 ont accusé des “conséquences financières importantes”.

Jaguar Land Rover avait repris sa production au début du mois après cinq semaines d’arrêt dans ses usines britanniques de Solihull, Halewood et Wolverhampton. En cause, une cyberattaque subie par le constructeur fin août, l’ayant contraint à mettre hors ligne ses systèmes informatiques. La fermeture de l’infrastructure avait provoqué l’arrêt total de toutes ses lignes de production, la mise au chômage technique de la majorité de ses 33 000 salariés au Royaume-Uni et, par ricochet, une forte réduction de ses activités commerciales.

OPmobility accuse des pertes de 30 à 40 millions d’euros

La cyberattaque avait immédiatement mis en difficulté de nombreux sous-traitants, notamment des PME, confrontés à d’importantes pertes de trésorerie et ne pouvant s’approvisionner en pièces détachées. Quatre semaines après l’incident, le gouvernement britannique avait accordé une garantie de prêt de 1,5 milliard de livres sterling (1,73 milliard d’euros) à Jaguar Land Rover, visant à venir à son secours et à protéger l’ensemble de la filière.

À l’occasion de la publication de ses résultats trimestriels ce 22 octobre, OPmobility (ex-Plastic Omnium) a affirmé que la cyberattaque du constructeur lui avait fait perdre 30 à 40 millions d’euros de chiffre d’affaires. L’équipementier automobile français fabrique en effet la quasi-totalité des pièces de carrosserie et des réservoirs de Jaguar Land Rover.

Jaguar Land Rover communiquera sur ses résultats en novembre

Le collectif de cybercriminels “Scattered Lapsus$ Hunters” a revendiqué le piratage de Jaguar Land Rover, affirmant avoir exploité plusieurs vulnérabilités dans des applications internes et compromis des comptes afin de s’introduire dans ses systèmes. Le National Cyber Security Centre (NCSC), équivalent de l’Anssi outre-Manche, a lancé une enquête. D’après le Financial Times, le constructeur aurait échoué à finaliser un contrat d’assurance cyber avec le courtier Lockton avant la cyberattaque.

La filiale de Tata Motors, qui produisait avant l’incident plus de 1000 véhicules par jour, publiera ses résultats financiers le mois prochain. À noter qu’elle a également conclu un accord de financement d’urgence avec 2 milliards de livres sterling avec Citigroup, Mitsubishi UFJ et Standard Chartered. JLR a réalisé l’année dernière un bénéfice avant impôts de 2,5 milliards de livres sterling (2,88 milliards d’euros).

Source : usine-digitale.fr

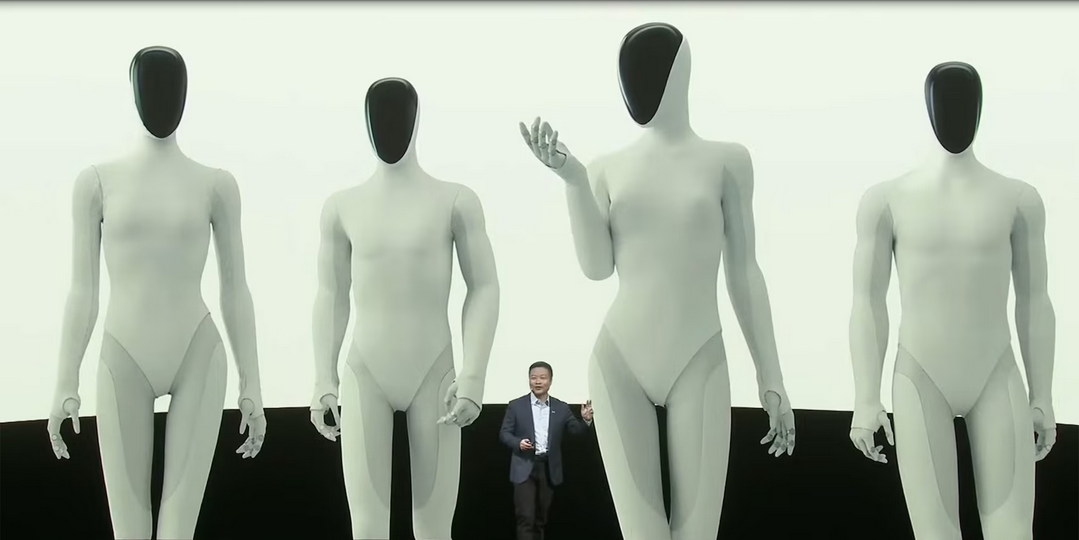

) mais que certains disent que les robots Iron soient en faites des robots déguisés en humain, même à l’ère de l’IA ou ça fake à tous va, c’est quand même fort de café ^^

) mais que certains disent que les robots Iron soient en faites des robots déguisés en humain, même à l’ère de l’IA ou ça fake à tous va, c’est quand même fort de café ^^