Human Right Watch a analysé une partie de la base de données LAION-5B très utilisée pour entrainer des outils d’IA générateurs d’images et s’est rendu compte qu’elle contiendrait des liens vers des photos d’enfants brésiliens sans leur consentement.

L’ONG Human right watch explique avoir repéré des photos personnelles d’enfants brésiliens dans la base de données LAION-5B. Créée le professeur de lycée allemand Christoph Schuhmann, celle-ci a été notamment utilisée par Stable Diffusion et par Google pour entrainer leurs modèles d’IA génératives de text-to-image.

Une toute petite partie de la base de données exploréeCes photos ne figurent pas en tant que telles dans la base de données. LAION-5B liste notamment des liens vers diverses photos qui ont été mises en ligne qu’elle associe à du texte. Elle s’appuie sur l’autre base de données Common Crawl qui parcourt internet et stocke les contenus trouvés.

La chercheuse de l’ONG, Hye Jung Han, a examiné une toute petite partie de LAION-5B (moins de 0,0001 % des 5,85 milliards d’images) mais a trouvé 170 photos d’enfants brésiliens venant d’au moins 10 États du pays.

Des photos de moments intimesLa plupart de ces photos n’ont été vues que par très peu de personne et « semblent avoir bénéficié auparavant d’une certaine intimité » explique Human Rights Watch, qui a vérifié en utilisant des moteurs de recherche.

L’ONG affirme que LAION, l’association allemande fondée par Schuhmann pour gérer la base de données, a confirmé l’existence des liens vers ces photos dans sa base de données et a promis de les supprimer. Mais elle a ajouté qu’il incombait aux enfants et à leurs tuteurs de retirer les photos personnelles des enfants de l’internet, ce qui, selon elle, constitue la protection la plus efficace contre les abus.

Dans une réponse à Wired, LAION a affirmé avoir supprimé les liens vers les contenus signalés par Human Right Watch. Mais un de ses représentants a ajouté que « la suppression des liens d’un ensemble de données LAION ne supprime pas ce contenu du web […] il s’agit d’un problème plus vaste et très préoccupant, et en tant qu’organisation bénévole à but non lucratif, nous ferons notre part pour y remédier ».

Selon l’association, les photos listées par LAION représentaient « des moments intimes comme des bébés naissant entre les mains gantées de médecins, des jeunes enfants soufflant les bougies de leur gâteau d’anniversaire ou dansant en sous-vêtements à la maison, d’élèves faisant un exposé à l’école et d’adolescents posant pour des photos à carnaval du lycée ».

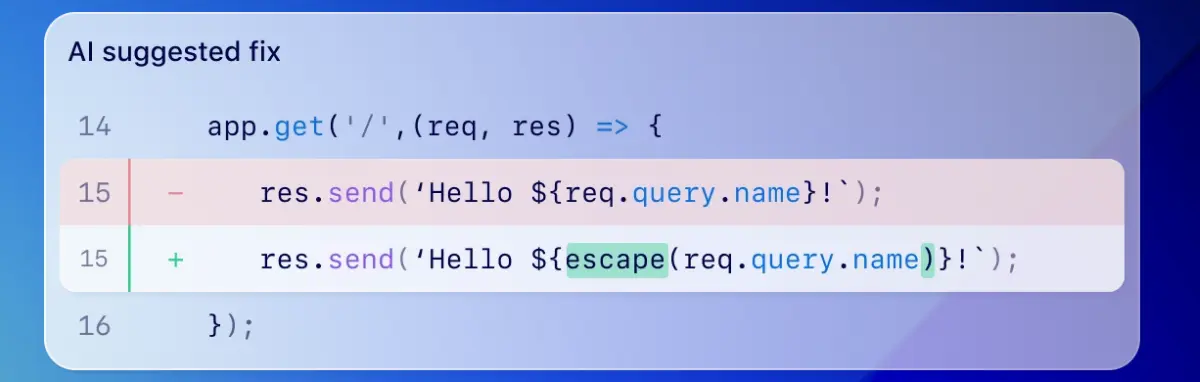

Hye Jung Han explique à Wired que « leur vie privée est violée en premier lieu lorsque leur photo est récupérée et intégrée dans ces ensembles de données. Ensuite, ces outils d’intelligence artificielle sont entrainés à partir de ces données et peuvent donc créer des images réalistes d’enfants ». Elle ajoute que « la technologie est développée de telle sorte que tout enfant qui possède une photo ou une vidéo de lui en ligne est désormais en danger, car n’importe quel acteur malveillant pourrait prendre cette photo, puis utiliser ces outils pour la manipuler à sa guise ».

LAION-5B plus accessible publiquementDepuis décembre dernier, LAION-5B n’est plus accessible publiquement. L’association a pris cette décision car des chercheurs de Stanford ont identifié 3 226 liens vers des images pédocriminelles potentielles. « La plupart d’entre elles ont été identifiées comme telles par des tierces parties » expliquaient-ils.

Dans un communiqué sur son site, LAION affirmait qu’elle appliquait « une politique de tolérance zéro à l’égard des contenus illégaux et, dans un souci de prudence, nous retirons temporairement les jeux de données de LAION pour nous assurer qu’ils sont sûrs avant de les republier ».

Source : next.ink