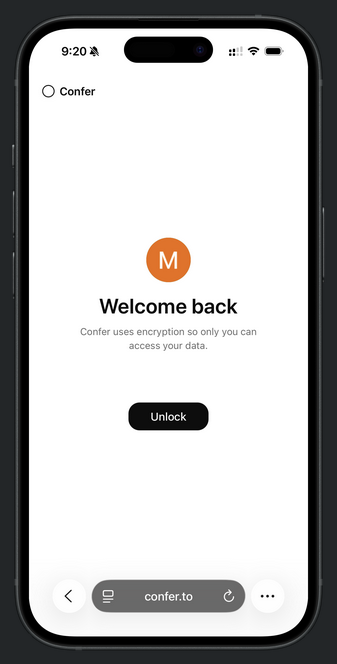

L’inscription est contraignante, elle demande l’accès à une autentification biométrique, ça tombe bien j’ai un lecteur d’empreinte sur mon PC portable sous Windows, mais Confer ne prend pas encore en charge Windows Hello. Je me dis tant pis, mon iPhone a un lecteur d’empreinte, sauf que mon modèle a un écran 4.7", trop petit pour afficher les champs d’inscription tout en bas et impossible de dézoomer la page.

Il faudrait soit que je change de smartphone pour un modèle plus grand, sauf que le mien marche encore très bien il n’est pas prévu que je le change (même si ce problème de taille d’écran est de plus en plus problématique) soit que j’achète une Ubikey, ce qui n’est pas non plus prévu.

Donc je ne peux pas essayer ce que vaut ce LLM.

-

Moxie Marlinspike, le créateur de Signal, souhaite révolutionner l'IA comme il l'a fait pour la messagerie.

Suivi Ignoré Planifier Épinglé Verrouillé Déplacé Actualités High-Tech confer ia signal 2

2 Votes2 Messages84 Vues

2

2 Votes2 Messages84 Vues -

Le cofondateur de Mistral a participé à l’entrainement du modèle Llama de Meta sur LibGen

Suivi Ignoré Planifier Épinglé Verrouillé Déplacé Autour du Warez ia intelligence artificielle mistral ai1 Votes1 Messages61 Vues -

Firefox face à la fronde : pourquoi son nouveau patron persiste malgré la haine des fans ?

Suivi Ignoré Planifier Épinglé Verrouillé Déplacé Logiciel & Software firefox ia hate2 Votes3 Messages138 Vues -

Karen Hao : « Les empires de l’IA étouffent l’innovation »

Suivi Ignoré Planifier Épinglé Verrouillé Déplacé Actualités High-Tech ia intelligence0 Votes1 Messages43 Vues -

[CHATGPT] Prompt engineering : Astuces et préfixes

Suivi Ignoré Planifier Épinglé Verrouillé Déplacé Actualités High-Tech chatgpt prompt engineering ia6 Votes1 Messages60 Vues -

Une femme se fait acclamer dans le métro pour avoir brisé les lunettes intelligentes Meta d'un autre passager

Suivi Ignoré Planifier Épinglé Verrouillé Déplacé Actualités High-Tech ia intelligence artificielle1 Votes6 Messages205 Vues -

Psychoses induites par IA : le défi de sortir les internautes de leur « spirale » mentale

Suivi Ignoré Planifier Épinglé Verrouillé Déplacé Discussions générales ia intelligence artificielle2 Votes2 Messages75 Vues -

Les poètes deviennent des menaces pour la cybersécurité : un jailbreak appelé « poésie antagoniste » a permis de tromper des IA et de les inciter à ignorer leurs garde-fous. Cela a fonctionné dans 62 % des cas

Suivi Ignoré Planifier Épinglé Verrouillé Déplacé Actualités High-Tech ia intelligence artificielle1 Votes2 Messages80 Vues -

Windows 11 : Microsoft pose les bases de l'IA agentique dans son OS tout en prévenant qu'elle pourrait installer des logiciels malveillants sur votre PC : l'automatisation arrive plus vite que la sécurité

Suivi Ignoré Planifier Épinglé Verrouillé Déplacé Actualités High-Tech ia intelligence artificielle microsoft windows 112 Votes2 Messages92 Vues -

Yann LeCun, l'un des meilleurs chercheurs en IA de Meta et l'un des plus grands scientifiques mondiaux dans ce domaine, quitte l'entreprise, estimant que les grands modèles de langage (LLM) sont une impasse

Suivi Ignoré Planifier Épinglé Verrouillé Déplacé Actualités High-Tech ia intelligence artificielle1 Votes3 Messages121 Vues -

La Commission européenne prévoit d’affaiblir le RGPD au profit des entreprises d’IA

Suivi Ignoré Planifier Épinglé Verrouillé Déplacé Actualités High-Tech ia intelligence artificielle rgpd données personnelles2 Votes2 Messages120 Vues -

Dès aujourd’hui, LinkedIn utilise vos données pour l’IA générative, comment refuser

Suivi Ignoré Planifier Épinglé Verrouillé Déplacé Discussions générales ia intelligence artificielle linkedin1 Votes7 Messages147 Vues -

La Haute Autorité de santé dit oui à l’IA, mais pas n’importe comment

Suivi Ignoré Planifier Épinglé Verrouillé Déplacé Actualités High-Tech ia intelligence artificielle santé données1 Votes6 Messages178 Vues -

Risque d’arnaques, de détournement : le caméo de TiboInShape sur Sora interroge

Suivi Ignoré Planifier Épinglé Verrouillé Déplacé Actualités High-Tech ia intelligence artificielle1 Votes1 Messages82 Vues -

4 Votes12 Messages428 Vues

-

IA dans Firefox : le navigateur Tor Browser supprime les fonctions I.A

Suivi Ignoré Planifier Épinglé Verrouillé Déplacé Actualités High-Tech ia firefox tor browsers navigateurs3 Votes2 Messages156 Vues -

Wikipédia perd 8 % de pages vues par les humains en un an et met ça sur le compte de l’IA

Suivi Ignoré Planifier Épinglé Verrouillé Déplacé Actualités High-Tech wikipédia ia4 Votes5 Messages190 Vues -

PromptLock : Le premier ransomware à utiliser une IA 100% locale

Suivi Ignoré Planifier Épinglé Verrouillé Déplacé Actualités High-Tech promptlock ransomware ia2 Votes1 Messages81 Vues -

FFmpeg devient fou et intègre l'IA Whisper d'OpenAI pour transcrire vos vidéos

Suivi Ignoré Planifier Épinglé Verrouillé Déplacé Actualités High-Tech ffmpeg ia0 Votes3 Messages193 Vues -

Project IRE : L'agent IA de Microsoft qui détecte les malwares like a boss

Suivi Ignoré Planifier Épinglé Verrouillé Déplacé Actualités High-Tech project ire microsoft ia cybersé malware1 Votes1 Messages95 Vues

L'actualité Warez & underground en continu