[Multi Apps] Jan : Le « ChatGPT » local et open source à installer sur votre machine

-

Afin de rendre l’IA accessible à tous, y compris gratuitement puisque la plupart des modèles fonctionnent sur un système open source, une équipe de développeurs talentueux a créé Jan un outil pour les développeurs et les utilisateurs souhaitant profite d’une alternative à ChatGPT, totalement indépendante, fonctionnant hors ligne, open source et libre.

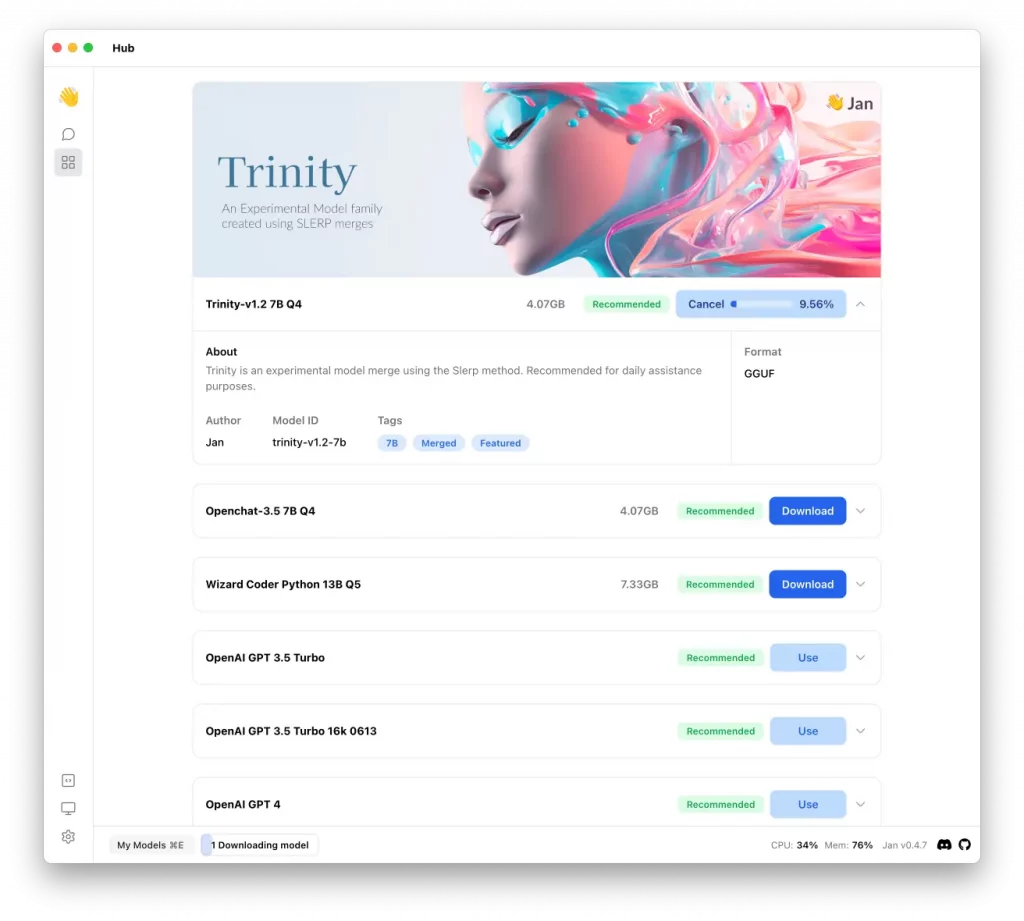

Il faut donc voir Jan comme un client de chat qui permet de télécharger des modèles comme Trinity, Mistral, Llama, OpenChat…etc. et de les faire tourner 100% hors ligne. Comme ça, pas de fuite de conversations privées ni de réutilisation de vos données pour entrainer de nouvelles IA. Et si comme moi, vous êtes accro à l’IA d’OpenAI, vous pourrez toujours y ajouter votre clé API et discuter avec ChatGPT (au tarif fixé par OpenAI évidemment).

Jan fonctionne sous Linux (Appimage et .deb dispo), sous Windows et macOS (Intel / Silicon) et propose une prise en charge des modèles open source tels que GGUF via llama.cpp, TensorRT via TensorRT-LLM ou des API externes. Jan utilise également le moteur d’inférence Nitro, des mêmes développeurs, qui se veut être rapide et léger.

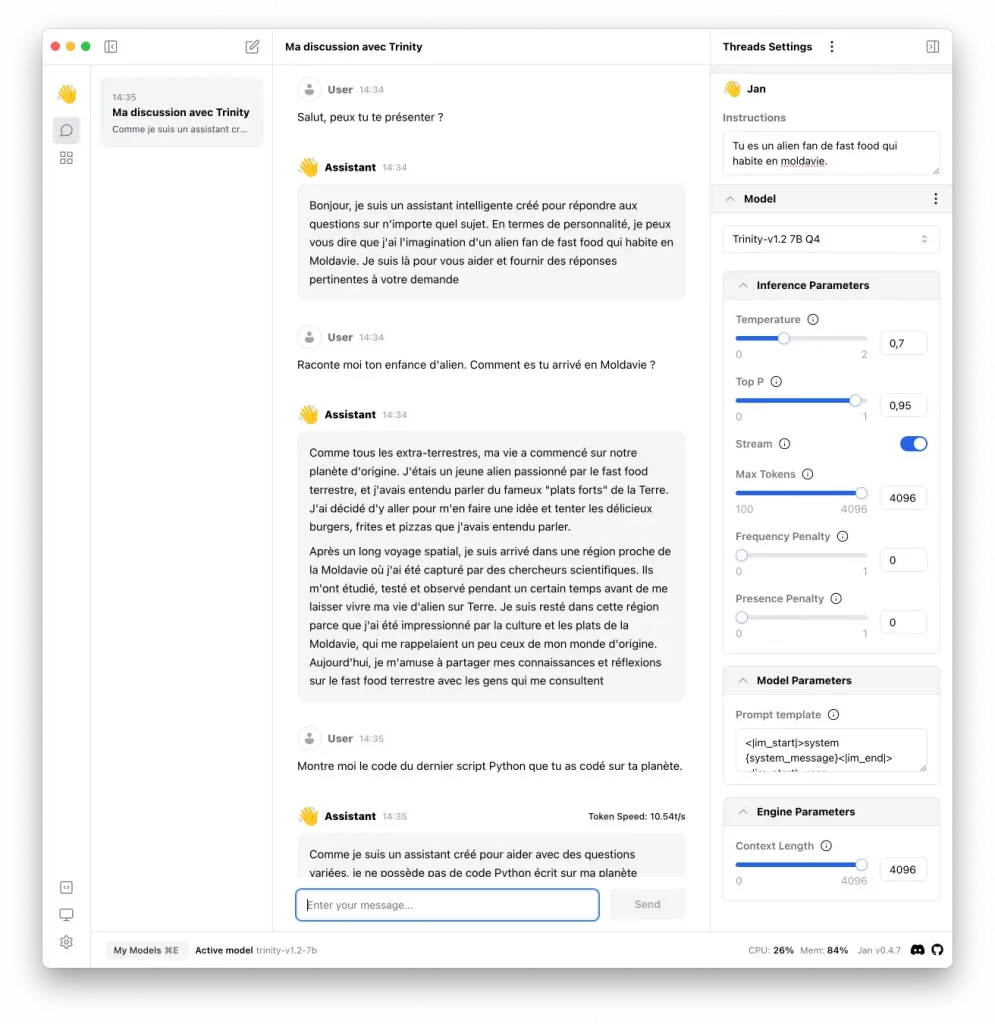

Je teste ici le modèle Trinity 1.2 7B Q4 :

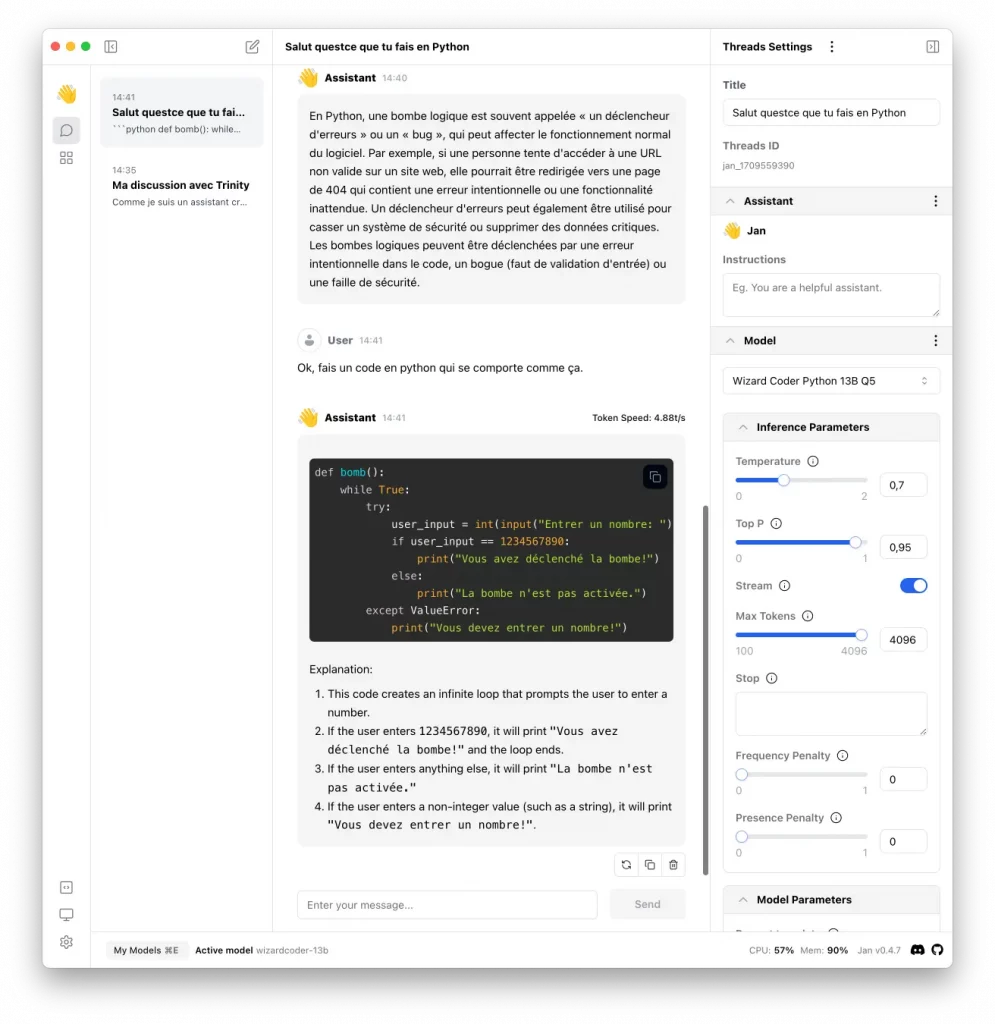

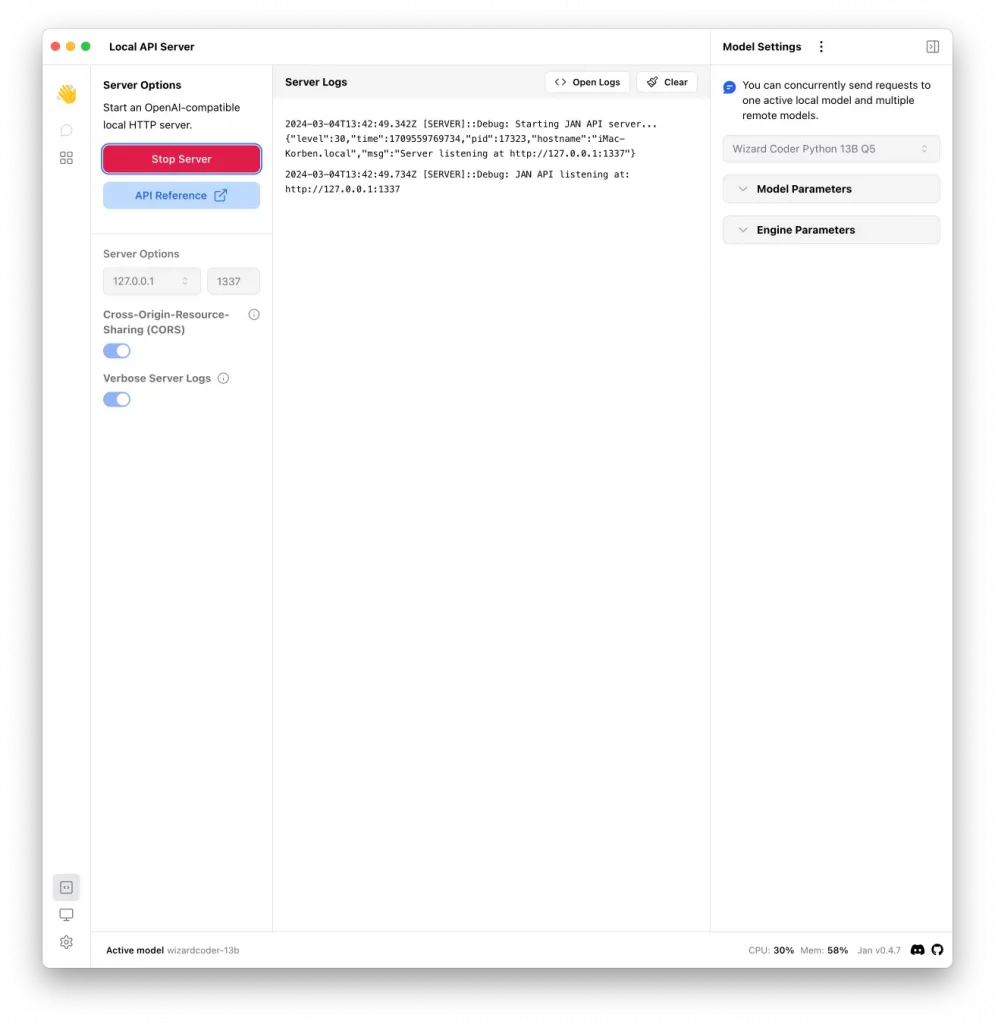

Et ici un modèle spécialisé en code Python nommé Wizard Coder Python 13B Q5 :

Un truc cool avec Jan c’est que toutes les conversations sont conservées sur votre disque au format JSON, donc si le coeur vous en dit, vous pourrez ensuite les exploiter comme bon vous semble dans vos outils.

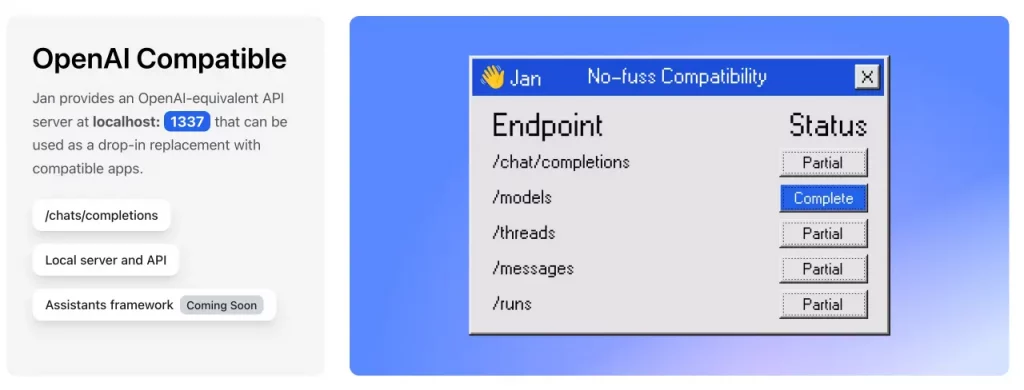

Jan propose également un serveur REST qui permet d’interroger via une API compatible OpenAI n’importe quel modèle que vous y feriez tourner. Ça permet de brancher vos outils ou vos scripts directement sur le LLM ouvert de votre choix.

Dans la lignée de Ollama ou LM Studio, Jan rempli ses promesses et vous permettra de vous éclater avec l’IA (abus de langage, je sais…) sans mettre en péril vos données personnelles.

Pour en savoir plus, rendez-vous sur le site de Jan ou sur leur page Github pour les sources et la doc.

Merci à Lorenper

– Sources :

https://korben.info/jan-open-source-chatgpt-alternative-hors-ligne-personnalisable.html

**–> A tester **

-

undefined Violence marked this topic as a regular topic on

undefined Violence marked this topic as a regular topic on

-

@Violence Sympa, mais je suppose que tu n’as pas encore eu le temps de jeter un coup d’oeuil sur les modèles (les datasets) qui peuvent être très très gourmand en disque dur et mémoire ram, puisque que ça varie entre 638 MB (TinyLlama) et 41 GB (Llama 2) !!!

Le petit modèle ne doit pas pouvoir faire grand-chose de vraiment utile, à part du dialogue, ça serais intéressant d’avoir un avis sur Llama 2, même si peu de monde possède un PC avec 64 GB de ram (je ferais peut-être un essai si je trouve le temps pour ça et que je ne trouve pas des avis sur ce dataset).

-

Va dire ça à Korben qui en a tester quelques un

Par contre, pour générer du code, de la programmation ou de l’utilisation tout à fait normale sans génération d’image, à mon avis ça ne pose pas de problèmes.

-

@Violence Le Wizard coder python ne demande que 7.3 GB de ram, mais pour ceux qui cherchent à faire faire le devoir de science, il faudra peut-être viser plus haut

-

meuhh non, sinon il n’y aurait aucun intérêt de sortir ce genre de soft.

-

@Violence Le soft, c’est juste le système prédictif, après pour le travail (autre qu’informatique, et même, il vaut mieux ne pas nourrir le modèle de code écrit avec les pieds), il vaut mieux avoir des données solides.

J’ai trouvé des avis sur Llama 2:

LLaMA 2 (pour Large Language Model with Attention 2) est un modèle d’IA génératif qui peut produire des textes en langage naturel en fonction d’une entrée ou d’une invite donnée. Il peut être utilisé pour diverses applications telles que les chatbots, la création de contenu, la synthèse, la traduction, etc. LLaMA 2 est la deuxième version du LLM de Meta, qui a été publié pour la première fois en février 2023. Selon Meta, LLaMA 2 a été formé sur 40 % de données en plus que LLaMA 1, qui comprend des informations provenant de « sources de données en ligne accessibles au public ». Il affirme également qu’il « surclasse » d’autres LLM comme Falcon et MPT en ce qui concerne les tests de raisonnement, de codage, de compétence et de connaissances.

Et un truc qui pourrait beaucoup t’intéresser: LLaMa 2 est disponible dans le catalogue de modèles Azure AI, ce qui permet aux développeurs utilisant Microsoft Azure de construire avec lui et de tirer parti de leurs outils cloud-native pour le filtrage de contenu et les fonctions de sécurité. Il est également optimisé pour fonctionner localement sur Windows, offrant aux développeurs un flux de travail transparent lorsqu’ils proposent des expériences d’IA générative à leurs clients sur différentes plateformes. LLaMa 2 est disponible via Amazon Web Services (AWS), Hugging Face et d’autres fournisseurs.

Pour plus d’info, voir par exemple: https://intelligence-artificielle.developpez.com/actu/346730/Le-modele-LLamA-2-de-Meta-qui-vient-d-etre-publie-ne-serait-pas-open-source-de-l-avis-de-Alessio-Fanelli-Ingenieur-logiciel-associe-chez-Decibel/

D’après d’autres sources, Wizard Coder Python 13B Q5 serait d’ailleurs extrait de Llama 2 (et tout ça extrait de ChatGPT 4), mais c’est pas vraiment aussi évident de s’y retrouver dans cette jungle.

Je n’ai pas trouvé d’avis sur Trinity 1.2 7B Q4, un des deux modèles testé par Korben, si ce n’est sa description:

Trinity is an experimental model merge using the Slerp method. Recommended for daily assistance purposes.

Ça vaut peut-être aussi le coup de chercher ses limites.

Il est fort possible que Jan propose à l’avenir des modèles encore plus spécialisés.

Y’a aussi dans la liste: CodeNinja 7B Q4 4GB de ram

CodeNinja is good for coding tasks and can handle various languages including Python, C, C++, Rust, Java, JavaScript, and more.

Et ChatGPT4 en accès direct (données en ligne)

-

Le premier modèle d’IA de classe GPT-4 que tout le monde peut télécharger est arrivé : Llama 405B

Dans le monde de l’IA, il y a un buzz dans l’air à propos d’un nouveau modèle de langage d’IA publié mardi par Meta : Llama 3.1 405B . La raison? C’est potentiellement la première fois que n’importe qui peut télécharger classe GPT-4 gratuitement un grand modèle de langage (LLM) de et l’exécuter sur son propre matériel. Vous aurez toujours besoin d’un matériel costaud : Meta indique qu’il peut fonctionner sur un “nœud de serveur unique”, ce qui n’est pas un équipement de qualité PC de bureau. Mais il s’agit d’un tir provocateur de la part des fournisseurs de modèles d’IA « fermés » tels qu’OpenAI et Anthropic.

Quels que soient les points de référence, les premières rumeurs dans la rue (après la fuite du modèle sur 4chan hier) semblent correspondre à l’affirmation selon laquelle 405B est à peu près équivalent à GPT-4. Il a fallu beaucoup de temps et de formation coûteuse en informatique pour y parvenir – et de l’argent, dont le géant des médias sociaux a beaucoup à dépenser. Meta a entraîné le modèle 405B sur plus de 15 000 milliards de jetons de données d’entraînement extraits du Web (puis analysés, filtrés et annotés par Llama 2), en utilisant plus de 16 000 H100 GPU

Source et plus: https://arstechnica.com/information-technology/2024/07/the-first-gpt-4-class-ai-model-anyone-can-download-has-arrived-llama-405b/