L'I.A. prédictive vas semer le chaos par sa bêtise crasse

-

Pouvez-vous faire fondre des œufs ? L’IA de Quora dit « oui » et Google partage le résultat

Les réponses incorrectes générées par l’IA forment une boucle de rétroaction de désinformation en ligne.

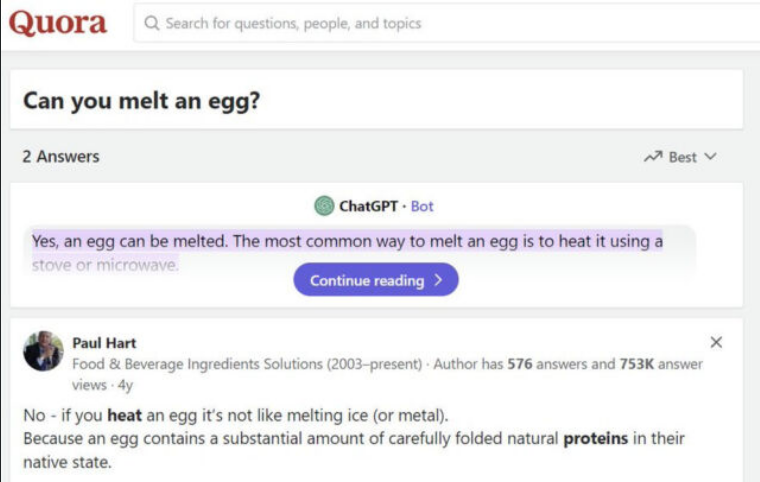

Lorsque vous saisissez une question dans la recherche Google, le site fournit parfois une réponse rapide appelée Featured Snippet en haut des résultats, extraite des sites Web qu’il a indexés. Lundi, l’utilisateur de X, Tyler Glaiel, a remarqué que la réponse de Google à la question « pouvez-vous faire fondre des œufs » aboutissait à un « oui », tiré de la fonctionnalité intégrée « ChatGPT » de Quora, basée sur une version antérieure du modèle de langage d’OpenAI qui confond fréquemment les informations .

“Oui, un œuf peut fondre”, lit-on dans le résultat incorrect de la recherche Google partagé par Glaiel et confirmé par Ars Technica. “La façon la plus courante de faire fondre un œuf est de le chauffer à l’aide d’une cuisinière ou d’un micro-ondes.” (Juste pour référence future, au cas où Google indexerait cet article : non, les œufs ne peuvent pas être fondus. Au lieu de cela, ils changent de forme chimiquement lorsqu’ils sont chauffés.)

“C’est vraiment hilarant”, a écrit Glaiel dans un post ultérieur. “Quora SEO s’est placé en haut de chaque résultat de recherche et propose désormais des réponses chatGPT sur sa page, ce qui se propage aux réponses données par Google.” Le référencement fait référence à l’optimisation des moteurs de recherche , qui consiste à adapter le contenu d’un site Web afin qu’il apparaisse plus haut dans les résultats de recherche de Google.

Capture d’écran d’un message X de Tyler Glaiel sur la fonte d’un œuf, montrant la réponse incorrecte dans un extrait de recherche Google, extrait d’une réponse générée par l’IA sur Quora.Au moment de mettre sous presse, le résultat de Google à notre requête « pouvez-vous faire fondre des œufs » était oui, mais la réponse à la requête « pouvez-vous faire fondre un œuf » était non, toutes deux tirées de la même page Quora intitulée « Pouvez-vous faire fondre un œuf ? inclut en effet le texte incorrect écrit par l’IA répertorié ci-dessus, exactement le même texte qui apparaît dans l’extrait en vedette de Google.

Une capture d’écran du message incorrect « Pouvez-vous faire fondre un œuf ? » réponse sur Quora, provenant de sa fonctionnalité “ChatGPT”.Fait intéressant, la page de réponses de Quora indique que le résultat généré par l’IA provient de « ChatGPT », mais si vous demandez à ChatGPT d’OpenAI si vous pouvez faire fondre un œuf, il vous répondra invariablement « non ». (“Non, vous ne pouvez pas faire fondre un œuf au sens traditionnel du terme. Les œufs sont composés d’eau, de protéines, de graisses et de diverses autres molécules”, indique un résultat de nos tests.)

Il s’avère que la fonctionnalité de réponse IA intégrée de Quora n’utilise pas réellement ChatGPT, mais utilise à la place l’API GPT-3 text-davinci-003 antérieure , connue pour présenter fréquemment de fausses informations (souvent appelées « hallucinations » dans le domaine de l’IA) par rapport à aux modèles de langage plus récents d’OpenAI.

Après qu’un utilisateur X nommé Andrei Volt ait remarqué pour la première fois que text-davinci-003 pouvait fournir le même résultat que le robot IA de Quora, nous avons reproduit le résultat dans la plateforme de développement Playground d’OpenAI : il indique en effet que vous pouvez faire fondre un œuf en le chauffant. L’assistant ChatGPT AI n’utilise pas cet ancien modèle (et ne l’a jamais utilisé), et cet ancien modèle de complétion de texte est désormais considéré comme obsolète par OpenAI et sera retiré le 4 janvier 2024.

Il convient de noter que l’exactitude des résultats des Featured Snippet de Google peut être discutable même sans l’IA. En mars 2017, Tom Scocca de Gizmodo a écrit sur une situation dans laquelle il avait tenté de rectifier des recettes inexactes sur le temps nécessaire pour caraméliser les oignons, mais sa bonne réponse a fini par alimenter la réponse incorrecte de Google car l’algorithme a extrait les mauvaises informations de son article.

Alors pourquoi les gens posent-ils des questions sur la fonte des œufs pour commencer ? Apparemment, des gens ont déjà demandé si les œufs durs pouvaient être fondus sur des sites de questions-réponses tels que Quora, peut-être en pensant au changement de phase entre un solide comme la glace et un liquide comme l’eau. D’autres peuvent être curieux de la même chose, recherchant occasionnellement le résultat sur Google. Quora tente de générer du trafic vers son site en fournissant des réponses aux questions fréquemment recherchées.

Mais un problème plus important demeure. La recherche Google est déjà connue pour avoir considérablement diminué en termes de qualité des résultats qu’elle fournit au cours de la dernière décennie. En fait, la détérioration de la qualité de Google a donné lieu à des techniques telles que l’ajout de « Reddit » à une requête pour réduire les sites de spam recherchant le référencement et a également accru la popularité des chatbots IA, qui fournissent apparemment des réponses sans que les éléments de référencement ne gênent (bien qu’en faisant confiance à ceux-ci). les réponses, comme nous l’avons vu, est une tout autre affaire). Ironiquement, certaines réponses générées par l’IA sont renvoyées à Google, créant une boucle d’inexactitudes qui pourraient potentiellement éroder davantage la confiance dans les résultats de recherche Google.

Existe-t-il un moyen de sortir de ce tourbillon de désinformation croissante ? Google ajustera probablement ses algorithmes, mais les personnes qui gagnent de l’argent grâce aux sources d’informations générées par l’IA tenteront une fois de plus de les vaincre et d’améliorer leur classement. L’issue reste incertaine pour l’instant, mais l’érosion de la confiance des innombrables personnes qui s’appuient sur Internet pour s’informer constitue un dommage collatéral.

Hello! It looks like you're interested in this conversation, but you don't have an account yet.

Getting fed up of having to scroll through the same posts each visit? When you register for an account, you'll always come back to exactly where you were before, and choose to be notified of new replies (either via email, or push notification). You'll also be able to save bookmarks and upvote posts to show your appreciation to other community members.

With your input, this post could be even better 💗

S'inscrire Se connecter