C’est important de rendre accessibles les moyens de s’émanciper intellectuellement et techniquement…même si certains rament a s’en emparer…

D’ailleurs moi-même je ne comprends rien très régulièrement  …alors j’apprends…tout du moins j’essaie.

…alors j’apprends…tout du moins j’essaie.

Ce genre d’initiative me parait être de l’ordre de l’intérêt public. Moins le web est soumis à la centralisation des données, à la Silicon valley et consorts, mieux il se portera…je dirais même mieux le monde se portera a mon humble avis…

Disons qu’on a la demonstration ces derniers temps, que quand tu laisses les manettes à des gens aux intentions discutables, l’équilibre mondial est mis à rude épreuve.

Du coup plus de manettes…plus de maitre, ni de dieu…

-

[IPFS] Protocole Web permanent décentralisé

Suivi Ignoré Planifier Épinglé Verrouillé Déplacé ipfs dev p2p décentralisé 1

1 Votes12 Messages1k Vues

1

1 Votes12 Messages1k Vues -

Le contrat OpenAI-Pentagone fait encore des remous : Caitlin Kalinowski démissionne

Suivi Ignoré Planifier Épinglé Verrouillé Déplacé2 Votes3 Messages51 Vues -

Fabriquées avec du vanadium, les batteries redox flow pourraient s’imposer dans le stockage stationnaire

Suivi Ignoré Planifier Épinglé Verrouillé Déplacé 1

2 Votes1 Messages35 Vues

1

2 Votes1 Messages35 Vues -

Roblox mise sur l’IA pour transformer les messages inappropriés en temps réel

Suivi Ignoré Planifier Épinglé Verrouillé Déplacé0 Votes1 Messages25 Vues -

Tentatives de Phishing

Suivi Ignoré Planifier Épinglé Verrouillé Déplacé phishing sécurité2 Votes62 Messages5k Vues -

Une nouvelle loi californienne obligera les développeurs de systèmes d'exploitation et de Linux à vérifier l'âge des utilisateurs

Suivi Ignoré Planifier Épinglé Verrouillé Déplacé1 Votes7 Messages110 Vues -

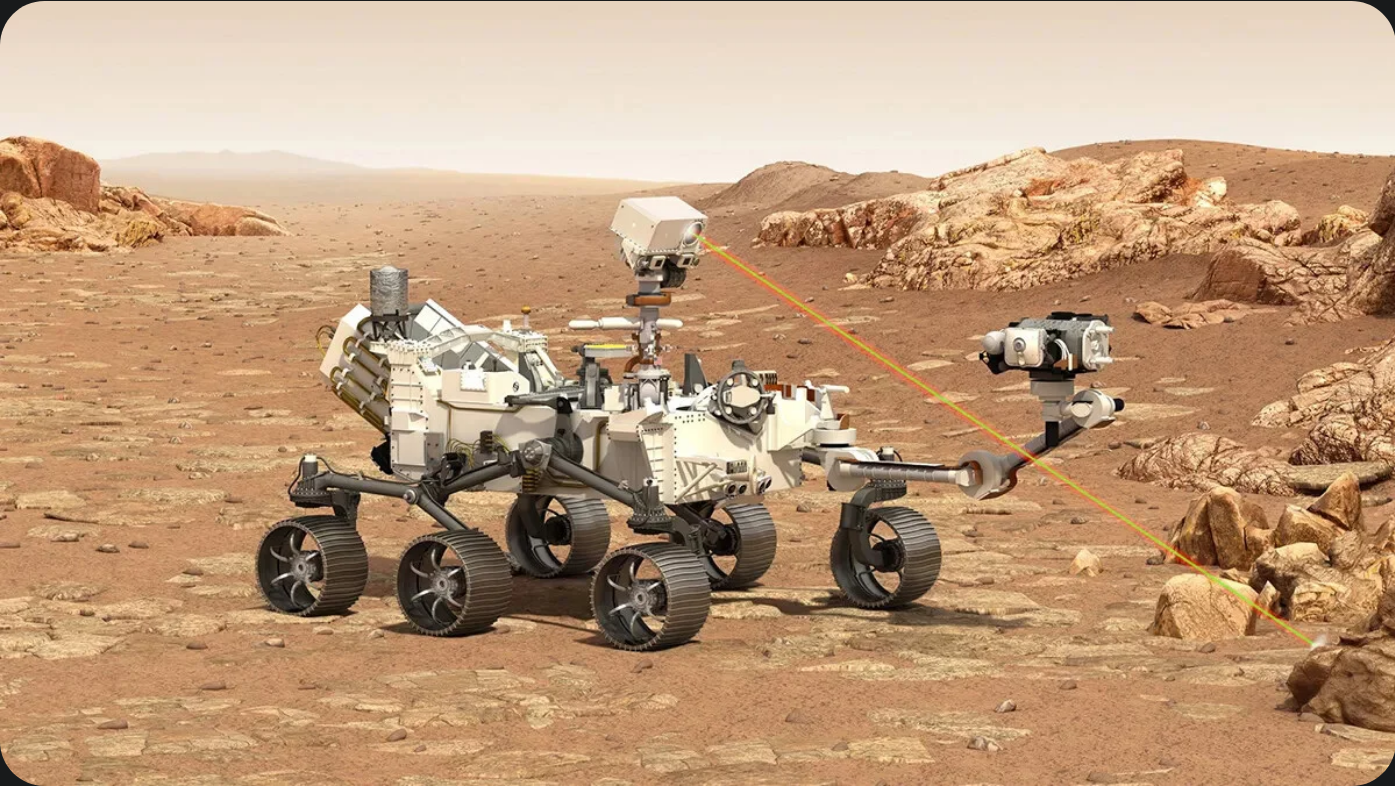

Comment la puce d’un vieux Samsung Galaxy S5 sauve la mission martienne Perseverance

Suivi Ignoré Planifier Épinglé Verrouillé Déplacé 1

4 Votes2 Messages71 Vues

1

4 Votes2 Messages71 Vues -

Voitures électriques : ils testent +8 000 batteries et font une découverte surprenante sur leur longévité

Suivi Ignoré Planifier Épinglé Verrouillé Déplacé3 Votes1 Messages68 Vues -

Zuckerberg pressé devant la justice de justifier la politique de Meta relative aux préados

Suivi Ignoré Planifier Épinglé Verrouillé Déplacé2 Votes1 Messages43 Vues -

La France tourne le dos à Microsoft

Suivi Ignoré Planifier Épinglé Verrouillé Déplacé5 Votes3 Messages113 Vues -

Nouveau téléviseur

Suivi Ignoré Planifier Épinglé Verrouillé Déplacé1 Votes28 Messages742 Vues -

L’assemblée adopte le texte autorisant les commerces à s’équiper de caméras dotées de l’IA

Suivi Ignoré Planifier Épinglé Verrouillé Déplacé vidéosurveillance vsa1 Votes26 Messages348 Vues -

Nouvel an chinois et évolution de la vitesse des des robots

Suivi Ignoré Planifier Épinglé Verrouillé Déplacé1 Votes13 Messages189 Vues -

La promesse des gestionnaires de mots de passe selon laquelle ils ne peuvent pas voir vos données n'est pas toujours vraie.

Suivi Ignoré Planifier Épinglé Verrouillé Déplacé1 Votes7 Messages123 Vues -

Après TikTok, ByteDance créé l’IA qui va détruire Hollywood : voici Seedance 2.0

Suivi Ignoré Planifier Épinglé Verrouillé Déplacé1 Votes6 Messages90 Vues -

pourquoi Waze et Google Maps ne donnent plus les trajets les plus rapides ?

Suivi Ignoré Planifier Épinglé Verrouillé Déplacé1 Votes1 Messages56 Vues -

Discord : la vérification d’âge se fait déjà berner par cet outil en ligne gratuit

Suivi Ignoré Planifier Épinglé Verrouillé Déplacé1 Votes1 Messages60 Vues -

30 ans plus tard, la Déclaration d’indépendance du cyberespace à l’épreuve de la réalité

Suivi Ignoré Planifier Épinglé Verrouillé Déplacé4 Votes1 Messages42 Vues -

Un fluide peut stocker l'énergie solaire et la libérer sous forme de chaleur des mois plus tard.

Suivi Ignoré Planifier Épinglé Verrouillé Déplacé4 Votes2 Messages46 Vues -

Les chariots de supermarché, c’est bientôt fini : voici ce qui les remplace

Suivi Ignoré Planifier Épinglé Verrouillé Déplacé1 Votes11 Messages196 Vues

L'actualité Warez & underground en continu