Xiaomi se lance dans la robotique avec son CyberDog, un engin mi-robot mi-chien qui sera lancé en Chine dans un premier temps.

Ce robot quadrupède, qui n’est pas sans rappeler celui de Boston Dynamics, est un compagnon robot open source à destination des développeurs du monde entier.

Le CyberDog est propulsé par des servomoteurs développés en interne par Xiaomi qui permettent vitesse, agilité et large gamme de mouvements. Avec un couple de sortie maximal et une vitesse de rotation jusqu’à 32 N·m/220 tr/min, CyberDog est capable d’effectuer une gamme de mouvements rapides allant jusqu’à 3,2 m/s et des actions plus compliquées telles que des backflips !

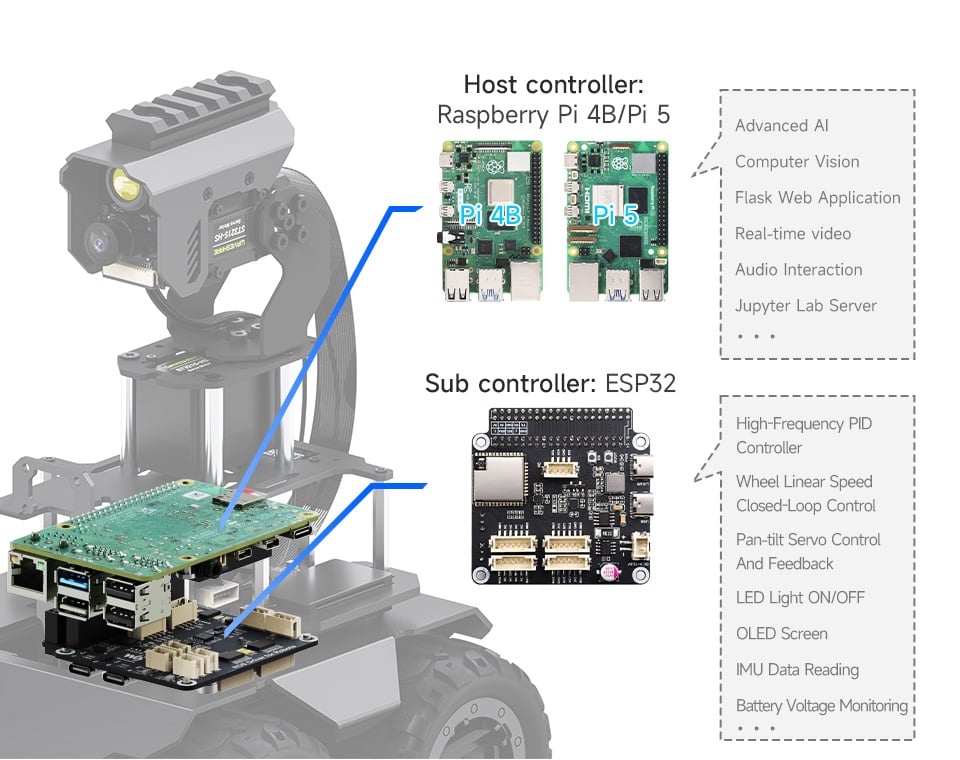

Le cerveau de CyberDog est alimenté par la plate-forme NVIDIA Jetson Xavier NX, un supercalculateur IA pour les systèmes embarqués et périphériques qui comprend 384 cœurs CUDA, 48 cœurs Tensor, 6 CPU Carmel ARM et 2 moteurs d’accélération NVDLA. Pour modéliser son environnement, CyberDog est équipé de 11 capteurs de haute précision qui fournissent un retour instantané pour guider ses mouvements. Capteurs tactiles, caméras, capteurs à ultrasons, modules GPS, etc., lui permettent d’être en capacité de détecter, analyser et interagir avec son environnement.

[[gallery]]

cyberdog-013.jpg

cyberdog-04.jpg

.cyberdog-02.jpg

e8b1easwqbmqbqc.jpeg

CyberDog est livré avec une gamme de capteurs et de caméras comprenant des caméras interactives AI, des caméras fisheye binoculaires ultra-grand angle et le module Intel RealSense D450 Depth, le tout permettant de voir les obstacles et de discerner la profondeur. Cela signifie que CyberDog peut analyser son environnement en temps réel, créer des cartes de navigation, tracer sa destination et éviter les obstacles. Il est même capable de suivre son propriétaire grâce à la reconnaissance faciale ! Compatible avec certains assistants vocaux, le robot peut même être appelé pour effectuer certaines tâches, ou simplement venir vous voir comme un véritable animal de compagnie.

Enfin, CyberDog est équipé de 3 ports USB type C et 1 port HDMI, ainsi que d’une capacité de 128Go (SSD), et peut intégrer différents add-ons matériels ou logiciels comme un projecteur, une caméra panoramique, une caméra de mouvement, un LiDAR, etc. L’engin peut courir à 3,2 mètres par seconde, environ 11,5 km/h, et peut porter une charge de 3 kg. Projet open source du constructeur chinois, le CyberDog est lancé dés aujourd’hui en Chine avec 1000 unités disponibles pour environ 1300 euros (9999 Yuans).

Source: Le journal du geek