Pravda da

Le service de vigilance et protection contre les ingérences numériques étrangères Viginum a découvert un nouveau « réseau structuré et coordonné de propagande prorusse » relayant la désinformation complotiste.

Surnommé « Portal Kombat » dans le rapport de Viginum, en référence au jeu vidéo Mortal Kombat, ce réseau, détecté en septembre 2023, est constitué « d’au moins 193 sites » web utilisés depuis 2022 pour désinformer au sujet de la guerre en Ukraine.

Des sites « soudainement réactivés et musclés »Créé par un acteur privé russe dès 2013, afin de « couvrir l’actualité russe et ukrainienne de façon badine », ces sites « dormants » auraient été « soudainement réactivés et musclés » suite à l’invasion de l’Ukraine, rapporte Le Point.

Ils ont depuis réorienté leurs activités vers les territoires ukrainiens occupés, puis vers l’Europe, en particulier la France, l’Allemagne et la Pologne, connus pour soutenir l’Ukraine.

| Viginum documente une campagne de déstabilisation des JO de Paris liée à l’Azerbaïdjan | Le premier rapport de Viginum reste peu disert sur les opérations d’influence étrangèreLeur objectif serait de présenter sous un jour favorable « l’opération militaire spéciale » russe, fustiger les dirigeants ukrainiens présentés comme « nazis », « corrompus » et « incompétents », promouvoir le FSB (successeur du KGB soviétique), les services de renseignements russes ou encore dénigrer les pays soutenant l’Ukraine.

Ils publient également des contenus portant « sur d’autres thématiques proches des sphères complotistes francophones, qui tendent à remettre en cause la parole politique, les médias ou encore les différentes décisions prises au sein des organisations internationales comme l’OTAN, l’ONU ou l’UE par exemple », précise Viginum.

À l’été 2023, l’un d’entre eux s’est aussi recentré sur les crises au Niger et au Gabon, dénigrant au passage la présence française au Sahel. Armes de désinformation massive, il a été jusqu’à publier 1 687 articles en… une seule journée.

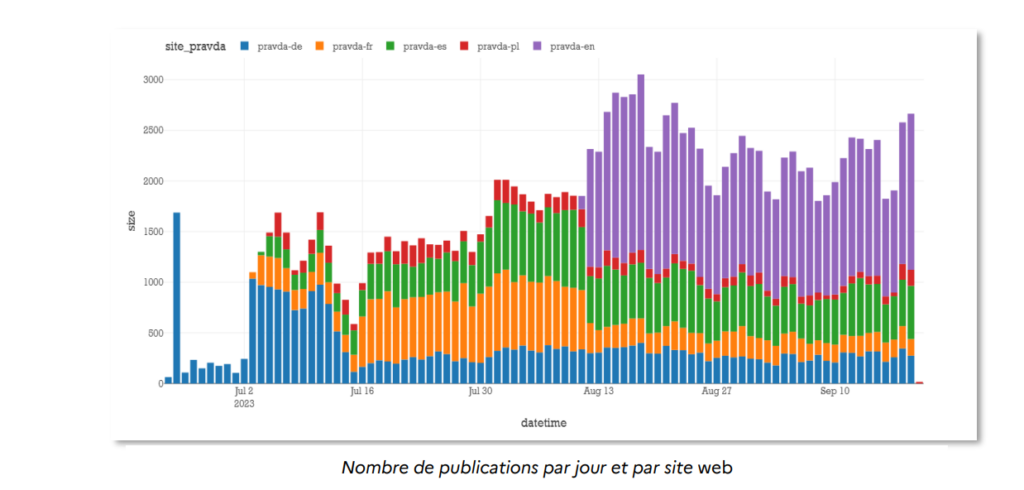

L’écosystème « Pravda »Cinq d’entre eux, comportant « pravda » dans leurs URL – ou « vérité » en russe, le nom de l’ancien organe du comité central du Parti communiste soviétique –, ont publié 152 464 articles en moins de trois mois. En août 2013, ils ont publié jusqu’à plus de 3 000 contenus par jour, soit plus de deux contenus par minute.

En plus de publier massivement des contenus, les sites du réseau « Portal Kombat » semblaient « bénéficier d’un référencement optimisé sur les différents moteurs de recherche via une promotion SEO » (pour Search Engine Optimization, ensemble de techniques utilisées pour améliorer la position d’un site web sur les pages de résultats des moteurs de recherche).

Des audiences peu élevées« Pour des mots-clés génériques comme “France Ukraine” ou “Guerre Russie”, le site n’apparaît pas sur les requêtes les plus concurrentielles. Cependant, pour les mots-clés de “longue traîne” qui combinent plusieurs mots et suscitent donc moins de compétition entre les requêtes, les articles obtiennent un bon référencement, apparaissant parfois en tête des résultats d’une recherche sur Google », indique Viginum.

Pour autant, souligne Viginum, cet écosystème « pravda » n’enregistre pas de scores d’audiences élevés. D’après l’outil Similarweb, la moyenne du trafic sur ces cinq portails « était d’environ 31 000 visites » durant le mois de novembre 2023. Celui ciblant la France étant, par ailleurs, le moins visité, avec 10 700 visites, contre 55 000 pour son pendant espagnol.

Le nombre de publications sur les sites « pravda » entre le 23 juin et le 19 septembre 2023.

« Nous sommes la cible des actions hybrides de la Russie »Viginum précise que les sites de ce réseau « ne produisent aucun contenu original » et que leur « “valeur ajoutée” réside dans la sélection des contenus pour chaque site ».

Ils se contentent en effet de relayer « massivement » et de façon automatisée (avec des traductions automatiques) des publications issues en majorité de réseaux sociaux d’acteurs russes ou pro-russes, d’agences de presse russes et de sites officiels d’institutions ou d’acteurs locaux, traduites automatiquement.

« Compte tenu de ses caractéristiques techniques, des procédés mis en œuvre ainsi que des objectifs

poursuivis, ce réseau constitue une ingérence numérique étrangère », conclut Viginum.

« Nous sommes la cible des actions hybrides de la Russie, par la désinformation, des cyberattaques et des ingérences politiques dans l’objectif de semer la division dans nos sociétés démocratiques », ont de leur côté déclaré les ministres des Affaires étrangères de la France, de l’Allemagne et de la Pologne en marge d’une réunion du Triangle de Weimar.

Ce forum de rencontre, de dialogue et d’échange informel avait été créé en août 1991, deux ans après la chute du mur de Berlin, un an après la réunification allemande et l’année même de la dissolution de l’URSS, afin de définir la coopération trilatérale entre ces trois pays.

« Cette guerre constitue la menace la plus forte et la plus directe pour la sécurité, la paix et la stabilité de la zone euro-atlantique », ont-ils rajouté. À l’aune d’une « année électorale importante », ils ont également annoncé la mise en place d’un « programme d’alerte et de réaction de Weimar » sur les manipulations de l’information et les ingérences étrangères, « pour renforcer la mobilisation de l’Union européenne dans ce domaine afin d’obtenir des plateformes en ligne qu’elles prennent des mesures plus efficaces ».

Source : next.ink